Dès qu’on a à sa disposition les Access Logs d’un site et un crawler, comme Screaming Frog, on peut faire une analyse combinée logs et crawls pour faire un recouvrement entre la façon dont est perçu votre site par Google et la façon que vous imaginez que Google voit votre site en raison de sa conception.

Utiliser les données de vos crawls et des Access Logs permet de faire des indicateurs composites qui donnent de nombreuses informations essentielles qui permettent de comprendre ce qui va et ne va pas dans l’explorabilité de votre site.

Voici donc la suite de l’article précédent qui traite de l’analyse des logs.

Principe de l’analyse combinée logs + crawls

Il s’agit d’établir les différences entre ce que “vous montrez” sur internet tel que vous l’avez imaginé, à l’aide d’un crawler, et ce que les moteurs de recherche voient et font sur votre site grâce aux Access Logs.

Y a-t-il une raison pour que Google voie autre chose que mon site tel que je l’ai imaginé ?

Oui ! Il y a toujours des différences :

- Certaines URL de votre site ne seront pas vues par Google ;

- Certaines URL qui n’existent pas seront vues par Google ;

Par exemple :

- Pages orphelines qui ne sont pas dans votre arborescence, mais qui sont link par des pages extérieures ;

- URL non identifiée par Google ;

- Problèmes techniques qui empêchent la page d’être vue par Google ;

- Pages jugées inutiles par Google et qui ne les indexera pas ;

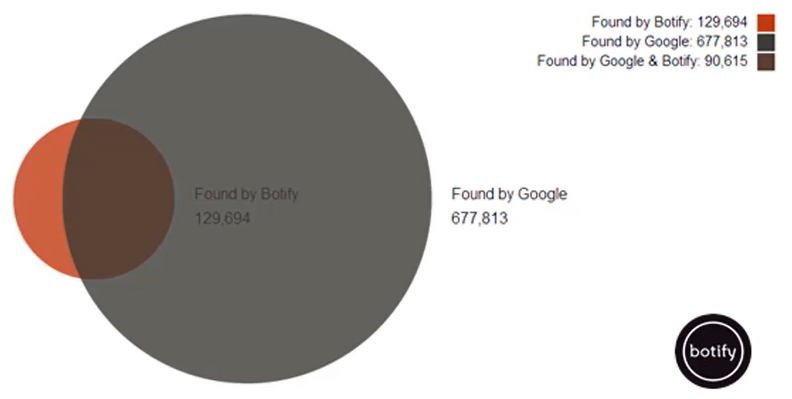

Pour réaliser l’analyse combinée, il faut comparer les URL crawlées par Google et les URL données par votre crawler.

L’intérêt est de traiter toutes les différences et les URL qui ne sont pas communes et identifier les causes de ces différences.

Quels outils pour faire l’analyse combinée ?

Cela va clairement être en fonction de la taille de votre site. Avec peu d’URL vous pouvez utiliser Excel ou Google Sheets. Dans les autres cas, il faudra adopter un outil dédié comme Botify ou encore OnCrawl pour les plus connus en France.

Vous avez donc maintenant des informations cruciales pour améliorer votre budget de crawl et votre référencement. À vous de jouer et de faire en sorte que les pages inutiles ne soient plus crawlées par Googlebot et que les autres pages soient toutes crawlées.

Que faire si je n’ai pas accès aux logs ?

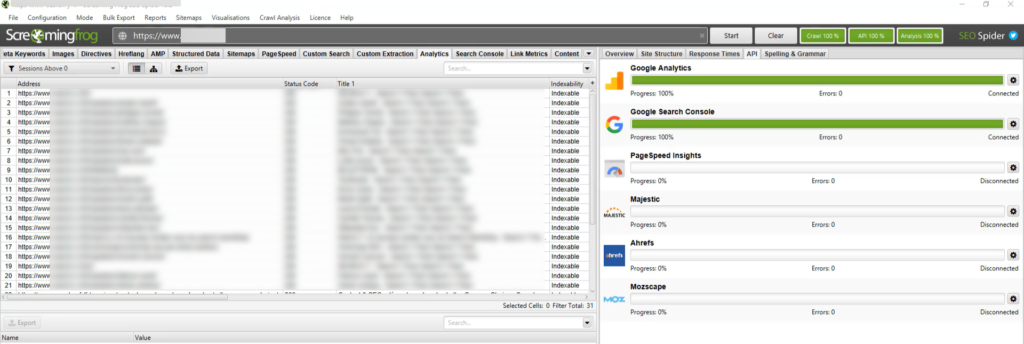

Vous pouvez également faire à peu près la même chose en combinant Screaming Frog avec la Google Search Console et Google Analytics.

En effet, en utilisant l’API de la GSC dans Screaming Frog, il est possible d’obtenir des informations intéressantes pour faire une analyse combinée.

Pour connecter une API à Screaming Frog, dans Screaming Frog, menu Configuration > API Access > Google Search Console et connectez votre compte. Faites de même pour Google Analytics.

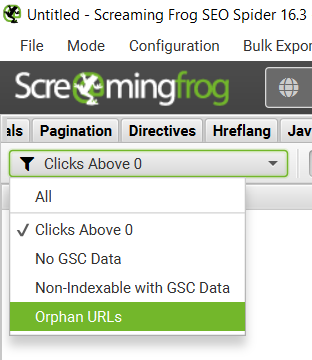

Vous allez ainsi pouvoir trouver des URL orphelines, c’est-à-dire des URL que vous allez trouver dans les rapports GA et GSC et qui ne figurent pas dans les URL crawlées. Pour ce faire, une fois le crawl SCF terminé avec les API, dans les onglets Analytics et Search Console, appliquez le filtre Orphan URLs. Il s’agit vraiment des URL à traiter en priorité !

Gardez à l’esprit que tous les cas ne seront pas détectés par cette méthode. Vous en aurez cependant une grande partie.

Comment traiter les pages orphelines ?

Pour mémoire, une page orpheline est une page identifiée par Google lors de son exploration, qui répond un code 200 et qui n’est pas rattachée à l’arborescence du site dont elle dépend.

Pour les traiter, il faut distinguer trois cas possibles.

- URL orpheline, doublon d’une URL existante, mais canonicalisée automatiquement par Google :

- Exemple : URL avec un paramètre en plus

- Très bien traité par Google

- Potentiellement sans impact sur le SEO

- Éventuellement, ajoutez la syntaxe au robots.txt (disalow) pour éviter le crawl inutile de ces URL par Googlebot

- URL orpheline, doublon d’une URL existante, pas de canonicalisation

- Impact SEO certain, à corriger

- Déclarer le paramètre comme inutile dans la Search Console

- ou ajouter une canonical

- ou rediriger la syntaxe vers la syntaxe canonique

- ou renvoyer une erreur 404

- URL orpheline, qui n’est pas un doublon

- Il faut créer un lien à partir d’une page de l’arborescence vers la page orpheline

- S’il s’agit d’une page obsolète oubliée, il faut que l’URL renvoie un code 404 ou 410 et non pas un code 200

Quels indicateurs de performance d’overlap analysis sont essentiels pour le SEO ?

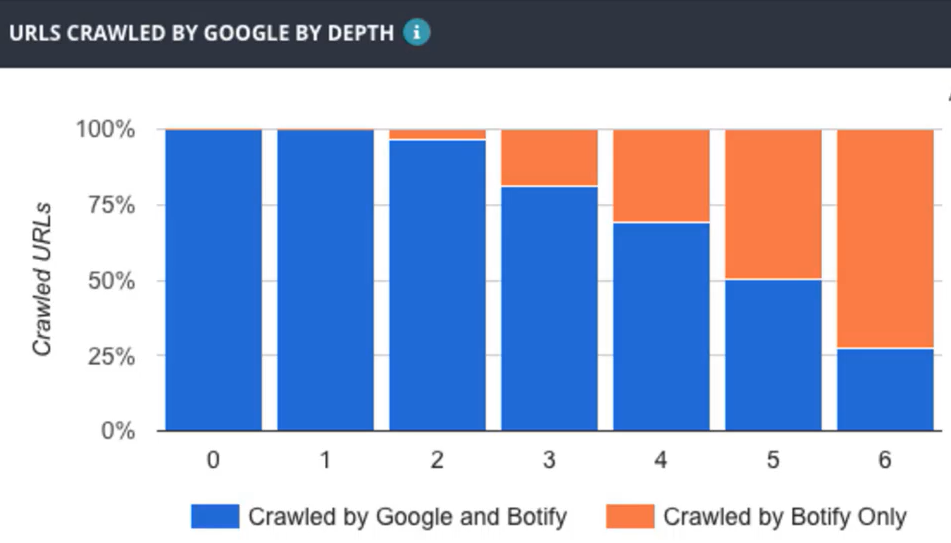

Le taux de pages crawlées

Il s’agit du ratio entre les pages crawlées par Googlebot et les pages crawlées par le crawler SEO.

Exemple taux pages crawlées selon la profondeur

Le taux de pages actives

Il s’agit des pages qui reçoivent au moins 1 visite par mois.

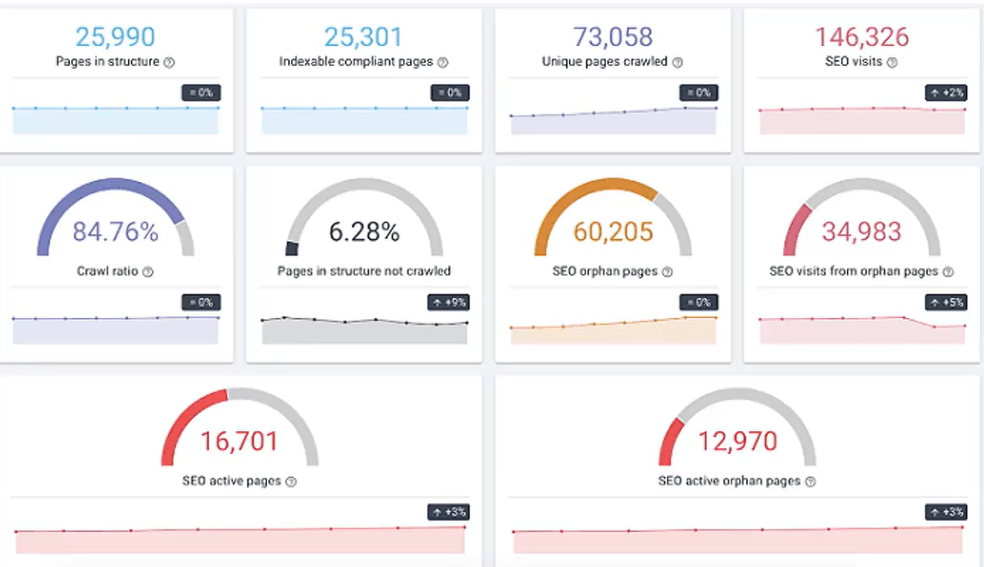

Dans notre illustration ci-dessous, qui est un dashboard Botify (OnCrawl propose un équivalent) en regardant les indicateurs :

- Nombre de pages dans la structure (trouvées par le crawler)

- Nombre de pages indexables

- Nombre de pages uniques crawlées

- Nombre de pages orphelines

- Nombre de pages actives

- Nombre de pages orphelines actives

On remarque très clairement que nous avons un problème de paramètre pris en compte par Google. Il faut que Google canonicalise ces pages avec les pages indexées ou mette en place une redirection vers la page qui fait réellement partie de l’arborescence.

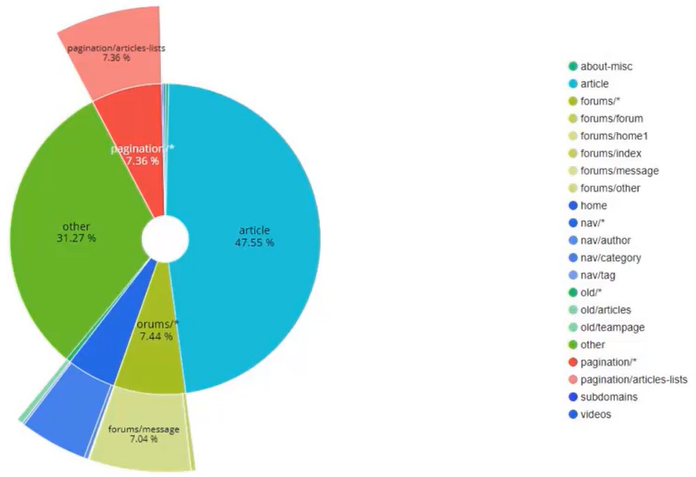

La catégorisation des pages

Cela permet, par segmentation, soit par type de pages, soit par univers (soit les deux) de savoir précisément où sont les problèmes. Cela évite de se perdre dans l’arborescence de sites très complexes avec des millions de pages.

Recentrer ses analyses est très important. C’est pourquoi la catégorisation doit être faite de façon rigoureuse et réfléchie.

Pages actives par catégorie

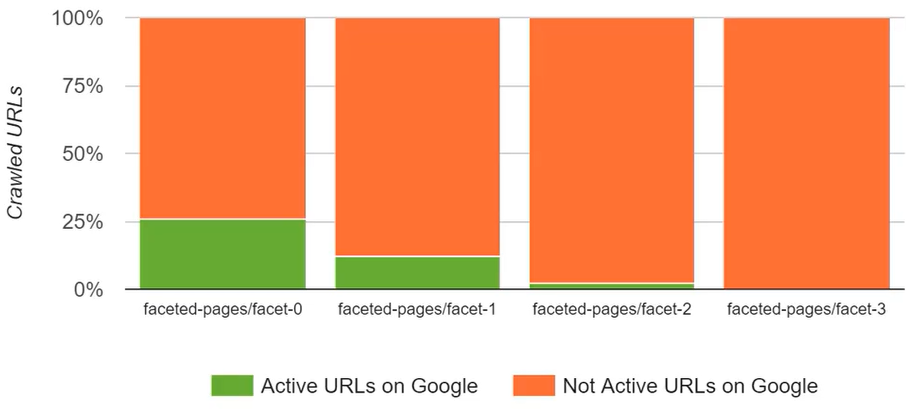

Dans notre illustration, les URL sont catégorisées par facettes (filtres) et cela permet de voir qu’il a des différences au niveau des activités des URL, celles qui reçoivent du trafic et celles qui n’en reçoivent pas. De cet exemple, il faudra se poser la question de la pertinence de maintenir certaines de ces facettes pour créer des pages d’atterrissages.

Il est important d’avoir un raisonnement réfléchi à ce sujet. Toutes les facettes doivent être supprimées dans ce cas ? NON ! L’activité des pages étant totalement dépendante de l’optimisation SEO réalisée dans sa globalité, dans certains cas il est totalement contre-productif de supprimer des URL inactives, car elles n’ont pas été optimisées correctement. Dans ce cas, il ne s’agit nullement de pages inutiles, il faut juste les optimiser pour qu’elles puissent devenir actives et avoir du trafic.

Vous le voyez, il ne faut donc pas aller trop vite en conclusion.

Je vous invite à vous pencher sur les overlap analysis et à prendre le temps nécessaire pour identifier et hiérarchiser les chantiers SEO qui en découleront.

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !