Dans notre premier article (si vous l’avez raté, il est ici), nous avons commencé à détailler la méthodologie pour détecter l’origine d’une baisse de trafic SEO. Après avoir bien vérifié l’exactitude des données en notre possession, et que la baisse n’était pas due à des causes extérieures, il ne reste que deux types d’hypothèse : elle est due soit à un changement sur le site, soit à un changement côté Google.

Pour parvenir à identifier correctement la cause, il ne faut pas regarder l’impact global. Il faut au contraire arriver à séparer clairement ce qui baisse et ce qui ne baisse pas. Déjà en regardant si les courbes de trafic et les courbes de visibilité montrent le même impact. Ensuite en regardant quel type de mots clés ou quel type de pages d’atterrissage est impacté.

3. Examiner le trafic et la visibilité

Cas 1 : le trafic SEO baisse, mais pas la visibilité

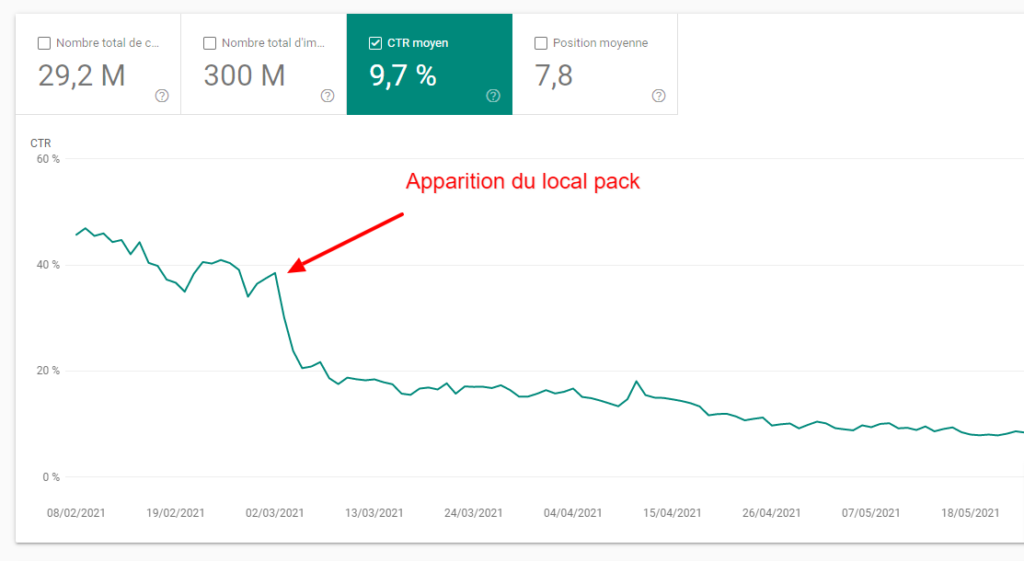

C’est logique et facile à comprendre : si votre visibilité reste la même, mais que votre trafic baisse, alors cela signifie que le changement est sur la page de résultats.

Les outils de mesure de la visibilité (Searchmetrics, Sistrix, Yooda, Ranxplorer, Myposeo, Semrush…) fournissent des courbes d’évolution d’un indice de visibilité, calculé sur des échantillons différents, et avec des formules différentes. Si vous le pouvez, c’est une bonne idée de se procurer les courbes provenant de plusieurs outils car ce qui est très visible sur l’un pourra être moins évident sur l’autre. Toutes ces mesures de visibilité sont par contre calculées sur le même principe : l’indice augmente avec le nombre d’urls du site visibles sur les requêtes de l’échantillon utilisé, mais aussi en fonction du nombre de fois où ces requêtes sont tapées par mois, et la position occupée par chaque url.

Si votre trafic SEO baisse (d’après votre solution de Web Analytics et aussi la Google Search Console), mais que votre visibilité reste stable, alors cela signifie qu’avec les mêmes positions qu’avant, Google vous envoie moins de trafic.

Puisque nous avons déjà éliminé des explications externes, comme la baisse d’intérêt pour votre marque, ou pour vos produits/services, il ne reste pas beaucoup de causes possibles.

- soit vos snippets ont changé, et ne génèrent plus autant de clics

- cas classique d’une régression ou d’un bug sur le title / meta description,

- ou des rich snippets qui ont disparu, soit du fait de Google, soit du votre : les données structurées ne sont plus alimentées ou sont buggées

- soit la page de résultats a changé

CONCLUSION : quand le trafic baisse, alors que la visibilité reste constante, sans chute des impressions, alors il faut chercher ce qui a changé sur les pages de résultats de Google !

Cas 2 : la visibilité chute très fort, le trafic beaucoup moins

C’est le cas le plus fréquent. Les outils de mesure de la visibilité ont tendance à « amplifier » les changements dans votre référencement. Parfois, vous ne détectez rien au niveau du trafic alors que les courbes des outils montrent une forte hausse ou baisse des indices de visibilité. C’est normal, cela signifie qu’il y’a bien eu des changements majeurs dans les positions occupées, mais que globalement, l’impact sur le trafic a été faible.

Et si la baisse de trafic est aussi faible, c’est peut-être du à des phénomènes externes comme la saisonnalité qui compensent la hausse. Ou à des gains de position sur des requêtes tapées très souvent qui sont sous-valorisées dans l’outil de mesure de validité.

Dans les deux cas, cela signifie qu’il se passe quelque chose de majeur dans le référencement de votre site et qu’il va falloir creuser un peu plus pour savoir l’origine de la baisse.

4. Rechercher des patterns

A ce stade, vous savez que quelque chose impacte lourdement votre référencement, mais vous ne savez pas exactement quoi.

Pour y voir clair, il faut chercher la réponse aux questions suivantes :

- les baisses de position impactent elles toutes les pages du site indifféremment, où seulement certaines d’entre elles ?

- les baisses de position concernent elles n’importe quel type de requêtes, où certaines d’entre elles seulement ?

Bref, on cherche un motif, un schéma récurrent dans les changements de position.

Dans cette tâche, la Google Search Console est notre amie. A condition de l’utiliser correctement.

Méfiez vous des biais de sélection

En effet, le réflexe que j’ai vu adopter par beaucoup, c’est de prendre le rapport sur la performance de recherches, de sélectionner les tops gadins pour les requêtes ou les pages d’atterrissage, et d’en déduire les urls impactées d’après la fréquence d’apparition de ces types d’urls dans les tops gadins…

Sauf que… ce n’est pas du tout la bonne méthode. Car cette approche est totalement biaisée par un autre biais que ceux cités dans le premier article : le biais de sélection.

En clair en prenant le « top gadins », vous ne regardez pas un échantillon représentatif des requêtes ou des pages d’atterrissages. Ce que vous regardez c’est le pire des échantillons : vous avez sélectionné uniquement les résultats les plus extrêmes !

Ce qu’il faut faire, c’est analyser les résultats sur une cohorte représentative d’une typologie de requêtes ou de pages d’atterrissage. Par exemple :

- L’impact sur les pages détail produits, versus les pages de listes de produits, versus les pages de listes de produits filtrées par tel ou tel critère, versus les pages vitrines / univers / la home

- L’impact sur les pages appartenant à différents univers produits : « high tech » vs « jardinage bricolage » vs « produits culturels » etc…

- L’impact sur les requêtes longue traine vs middle tail vs short tail (on peut raisonner sur les deux définitions de la longue traine : les requêtes produisant un trafic inférieur à un certain seuil avant la baisse vs les autres, ou les requêtes comportant plus de X mots clés, vs les autres)

- L’impact sur les requêtes brandées vs non brandées

- L’impact sur les requêtes appartenant à des groupes de requêtes particuliers (contenant un ou plusieurs mots clés caractéristiques)

Pour y parvenir, vous aurez probablement besoin d’utiliser les expressions régulières dans les filtres de la GSC. Je vous invite à lire notre article sur ce sujet :

Ok, je vois un schéma récurrent, mais qu’est-ce que je peux tirer comme conclusion ?

Les conclusions sont différentes si la baisse de trafic et/ou de visibilité impacte spécialement un type de pages d’atterrissage, ou un type de requêtes…

Si c’est un type de pages d’atterrissage qui est impacté, et pas les autres, cela signifie que la cause de la baisse est bel et bien associée à ce template :

- soit il y’a eu un changement technique, de layout ou de contenu sur ces pages : alors il est probable que la baisse est liée à ce changement (à condition qu’il y’ait bien concomitance entre le changement et la baisse, et que l’effet ne précède pas la cause).

- soit vous savez que le site n’a pas changé : dans ce cas, cela veut dire que d’un seul coup, Google a déclassé ce type de pages. Puisque vous avez déjà éliminé les causes extérieures, cela signifie :

- soit que ces pages ont vu leurs scores baisser sur un ou plusieurs critères

- soit que Google a changé le poids des scores de ces pages, sans que ces scores aient changé

- dans les deux cas, la cause est liée à l’algorithme de classement de Google !

Attention à ne pas passer à côté d’un changement sur votre site dont vous n’êtes pas informés. Pensez à vérifier avant de vous de prononcer le maillage et les liens de navigation, les données structurées, les erreurs dans la search console, le robots.txt, le rapport de couverture de la GSC, et cherchez à détecter des régressions à l’aide d’un crawler.

Mettez aussi en place avec vos dev un fonctionnement qui vous permet d’avoir les dates du moindre changement apporté au site ou à son hébergement, cela vous permettra de soupçonner plus facilement la survenance d’une régression et de pouvoir regarder au bon endroit.

Oui mais si en fait, je ne vois aucun schema récurrent ?

Notez bien qu’il arrive que ces analyses soient infructueuses : quel que soit le découpage que vous adoptez pour comparer des types de pages d’atterrissage ou des requêtes, le phénomène peut sembler avoir le même impact partout. Si vous pensez avoir segmenté vos pages d’atterrissage et vos requêtes selon toutes les dimensions pertinentes, alors c’est déjà un enseignement.

- une baisse uniforme partout est rarement due à un problème technique. Sauf si ce problème technique est susceptible d’impacter toutes les urls de la même façon, comme un beau « disallow: / » dans le robots.txt

- une baisse uniforme partout est parfois due à une baisse importante de pagerank : regardez dans Majestic ou Ahrefs (ou dans vos logs) si vous n’avez pas récemment perdu un gros Backlink.

- Si vous ne voyez rien, surveillez le crawl : si le rythme de crawl et de recrawl baisse, c’est souvent dû à une baisse de PR. Cela vous permettra de détecter que Google a peut-être annulé le linkjuice d’un ou plusieurs gros backlinks que Google estime être des liens manipulés.

- la cause la plus fréquente est l’impact d’un filtre algorithmique de Google ou à une « action manuelle ». Pour faire la différence c’est simple : si c’est une action manuelle, vous trouverez un message vous expliquant que vous avez subi une pénalité, et la nature de la pénalité. En l’absence de message, c’est un filtre algorithmique ou l’impact de l’algorithme de classement de Google. Remarque : toutes les actions manuelles ne portent pas sur l’intégralité des pages du site, certaines cibles des parties de votre site

Analysez l’historique de la baisse pour vous aider à identifier la vraie cause

L’analyse de l’existence de patterns est nécessaire pour y voir clair, mais pas suffisante.

En effet, il est souvent intéressant de s’intéresser au facteur temps autour de cette baisse, cela aide à éliminer des hypothèses :

- la perte est-elle brutale ou progressive ?

- la baisse est-elle concomitante avec un autre événement ?

Si la baisse est brutale (elle survient d’un jour sur l’autre, au maximum deux ou trois jours), cela signifie que vous avez perdu d’un coup de la visibilité. Cela ne peut s’expliquer que par un changement chez Google, soit un changement dans l’apparence de ses pages de résultats (l’impact est hyper rapide), soit un changement dans son algorithme de classement (là le temps nécessaire pour voir l’impact varie beaucoup d’un changement à l’autre). Si la baisse est brutale et ne concerne que certaines pages, c’est sans doute due à l’injection brutale dans l’algorithme de classement de mises à jour de certains scores qui ne sont évalués que de temps en temps.

Si la baisse est rapide, mais sur plus de deux ou trois jours : alors c’est probablement l’impact d’un changement dans l’algorithme de Google, mais qui prend du temps pour être déployé complètement.

Si la baisse est progressive, sur une période s’étalant sur plusieurs semaines : alors cela signifie que vous baissez dans les classements probablement au fur et à mesure que vos pages sont crawlées. Cela peut provenir de la prise en compte de changements sur votre site au rythme de recrawl de vos pages (hypothèse que vous pouvez vérifier en regardant ce qui se passe dans vos logs : il suffit de comparer les dates de dernière visite de Googlebot sur une url et la date de la perte de position qui s’en suit). Ou bien, il s’agit de l’impact d’une nouvelle version de l’algorithme qui recalcule vos nouveaux scores au fur et à mesure que vos pages sont crawlées ou recrawlées.

Concomitance et causalité et l’effet ne peut pas précéder la cause

Puisque l’on parle de temporalité, il faut aborder un sujet qui donne souvent prise aux biais d’ancrage ou aux biais de confirmation.

Si vous avez entendu d’une update de Google, et que vous voyez une baisse de trafic SEO sur votre site, vous risquez fort de vous dire « ah ok, la baisse est due à la mise à jour TRUC ».

Pourquoi pas, mais attention :

- ce n’est pas parce que deux événements arrivent en même temps que l’un est la cause de l’autre. Il faut tester toutes les autres hypothèses, sinon vous compterez parmi les nouvelles victimes du biais de confirmation

- en aucun cas, l’effet peut précéder sa cause. Attention : il y’a parfois des décalages entre le début du déploiement d’une mise à jour aux USA et en France. Il faut bien se renseigner pour savoir si telle ou telle mise à jour annoncée par Google à une certaine date a bien été déployée chez nous ce jour là. Même si la mise à jour est appliquée partout en même temps, il arrive fréquemment que la date soit décalée d’un jour pour la France à cause du décalage horaire entre Mountain View et Paris, soit 9 heures ! Donc une mise à jour lancée dans l’après midi en Californie intervient en même temps dans la nuit du lendemain en France.

- Donc si vous voyez un effet avant que la mise à jour ait été réellement déployée, cela signifie que la mise à jour ne peut pas être la cause de la baisse de trafic. La proximité des événements est potentiellement une simple coincidence !

- si la baisse intervient trop longtemps après la fin du déploiement d’une mise à jour : ce n’est probablement pas la cause non plus. La difficulté ici c’est que Google ne communique pas toujours sur la fin du déploiement de telle ou telle mise à jour.

5. Formulez des hypothèses et analysez ce qu’elles impliquent pour les infirmer ou les confirmer

Bon, à l’issue de toutes ces analyses, vous êtes en mesure de formuler plusieurs hypothèses. Le plus important est d’appliquer une méthodologie hypothético-déductive au fur et à mesure de vos travaux, pour ne retenir que les hypothèses qui tiennent la route.

- vous formulez toutes les hypothèses pouvant expliquer une baisse de trafic

- vous vous concentrez sur ce que ces hypothèses impliquent en tant qu’effet visible

- exemple : si quelque chose a changé dans la page de résultats de Google, mais pas sur mon site, et pas dans l’algorithme, alors je dois voir une baisse de trafic SEO mais pas de baisse de visibilité. Si par contre je vois qu’il y’a une baisse de visibilité nette, alors je sais que mon hypothèse est infirmée, et que je peux l’abandonner

Attention, cela ne marche que dans un seul sens : si l’hypothèse A se traduit par un effet B, alors l’absence d’effet B signifie que l’hypothèse A n’explique pas la baisse. Mais la présence de l’effet B n’implique pas que A est la cause ! Là encore, un peu de connaissance de la logique aide à ne pas faire d’erreur de raisonnement.

Du coup, on invalide plus facilement des hypothèses qu’on ne les valide. Car si A implique B et C et D, et que l’on s’aperçoit que les effets B, C et D sont bien là, cela ne veut pas dire que l’hypothèse A est la bonne ! Cela signifie juste que l’on a pas encore trouvé d’éléments qui invalident A. Bref, que l’hypothèse tient la route jusqu’à la preuve du contraire.

Le résultat d’une approche rigoureuse dans l’identification des causes d’une baisse, c’est donc en général de finir avec plusieurs hypothèses plausibles… Parfois beaucoup !

Pour y voir plus clair, travailler à plusieurs est recommandé

6. Discuter de vos conclusions avec d’autres personnes

Si vous n’avez pas trouvé comment infirmer certaines hypothèses, le plus sage est d’échanger vos points de vue avec différentes personnes.

L’idée est de leur demander pourquoi, selon elles, certaines hypothèses que vous avez retenues ne tiennent pas la route. On ne pense pas toujours à tout, et avoir diverses approches du problème est d’un grand secours.

Ces personnes extérieures peuvent également faire ressortir que vous avez été victimes de biais de confirmation ou de biais d’ancrage. C’est intéressant de choisir comme interlocuteurs des personnes dont les « croyances » en matière de SEO ne sont pas les mêmes que les vôtres.

Cela devrait vous permettre de réduire la liste des hypothèses de manière significative.

Mais même comme cela, on finit souvent avec sur les bras non pas une cause plausible, mais plusieurs…

Plusieurs causes plausibles ? et si leurs effets se cumulaient ?

Bon déjà, n’éliminez pas la possibilité que ces causes peuvent s’empiler… Je suis souvent tombé sur des cas où les spécialistes SEO in house avaient été tournés en bourrique en cherchant une explication à une baisse en faisant des raisonnements sur l’impact attendu d’une cause sur le trafic. Et ils avaient infirmé pas mal d’hypothèses valables en disant des choses du genre : « si ce problème technique était la cause de la baisse, l’impact serait de -5%. Comme la baisse est de -30%, cela ne peut pas être la cause ».

Sauf que le raisonnement est faux : l’effet « vrai » n’est pas de -5% exactement, mais d’au minimum -5%. Il ne fallait pas éliminer cette hypothèse, car c’était l’une des causes, avec d’autres, dont l’effet cumulé atteignait les 30%.

Plusieurs causes plausibles ? Mais du coup je fais quoi ?

Mais dans le cas le plus fréquent, ce que l’on obtient à la fin de l’analyse, ce n’est pas une cause unique, clairement identifiée (heureusement cela arrive quand même). On se retrouve avec plusieurs explications possibles… Chacune tenant la route.

Bon cela énerve les patrons, qui auraient été plus rassurés si on était capable d’identifier les causes de manière simple à chaque fois. Sauf que l’exercice est hyper compliqué, et Google s’ingénie à ne pas nous faciliter la tâche en n’étant pas très transparent sur de nombreux sujets… Bref, il faut assumer le fait que c’est déjà très bien si on a réduit le nombre d’hypothèses de manière considérable !

Mais après tout dans la vraie vie on se fiche de ne pas savoir exactement pourquoi on a perdu des plumes en référencement : car l’important, c’est d’avoir un plan pour récupérer le trafic perdu.

7. Construire un plan pour récupérer le trafic

La vraie tâche utile derrière ces analyses, c’est de construire un plan pour récupérer le trafic perdu.

On part de l’hypothèse retenue, on essaie de comprendre où le bat blesse : pourquoi les scores ont baissé, ou comment faire monter les scores, ou comment réparer un problème technique, ou comment regagner en visibilité quand Google vous a fait disparaitre à grands coup de local pack et de positions zéro, etc… etc…

Et on bâtit une roadmap pour dérouler les actions correctives.

Et si vous restez avec plusieurs hypothèses sur les bras : vous faites strictement la même chose, plusieurs fois. Bref, vous essayez de corriger tout ce qui est lié aux différentes causes possibles. Si vous avez été rigoureux dans vos analyses et vos raisonnements, une ou plusieurs de vos hypothèses sont justes. En appliquant tous les correctifs, ceux qui corrigent les vraies causes de la baisse seront déployés, et en toute logique, un effet positif sur le trafic s’ensuivra.

Conclusion : identifier les causes d’une baisse de trafic SEO, ce n’est pas si simple à faire

A l’issue de ces deux articles, j’espère que vous avez compris à quel point l’exercice demandait de la rigueur, de la méthode et de l’expérience pour être mené à bien sans erreur…

Je vous ai indiqué une méthodologie tirée de mon expérience de quinze ans en SEO. J’espère que cela pourra vous aider dans vos investigations en cas de baisse de trafic.

N’hésitez pas à me poser des questions en commentaire, j’y répondrai avec plaisir.

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !