Si vous faites de la veille SEO ces derniers mois, vous avez forcément vu passer la nouvelle hype autour du GEO (Generative Engine Optimization) : la distribution de contenu au format Markdown (.md) spécifiquement pour les agents d’intelligence artificielle (crawlers OpenAI, Claude, Google AI Overviews).

Spoiler Alert : ce n’est pas parce que des gens proposent des solutions pour le faire parce qu’il y’a une demande (business is business) que c’est intelligent de le faire.

Des initiatives comme le fichier llms.txt ou la récente fonctionnalité « Markdown for Agents » de Cloudflare promettent de transformer notre HTML en un flux Markdown épuré, réduisant le coût en tokens pour les LLMs de près de 80 %.

Sur le papier, c’est le rêve pour faciliter le travail des IA. Sauf qu’en réalité, d’un point de vue purement SEO et acquisition de trafic, servir du Markdown aux moteurs de recherche est une fausse bonne idée. Voici pourquoi les géants du search déconseillent fortement cette pratique.

La perte du contexte UX et le piège de la maintenance

Le principal argument de Google et Bing contre les fichiers Markdown réside dans leur philosophie de base : ils classent les pages en fonction de ce que l’utilisateur voit et expérimente. Fabrice Canel (Bing) l’a résumé de manière cinglante : « Dans l’ère de l’IA, nous comprenons parfaitement les pages web, pas besoin de sous-standards. Pensez-y : nous classons en fonction de ce que voient les clients. »

En servant du Markdown (même proprement via l’en-tête HTTP Accept), vous privez les moteurs de signaux cruciaux liés à l’UX :

- Le layout et l’ergonomie de la page.

- Le placement du contenu principal (au-dessus ou en dessous de la ligne de flottaison).

- L’intégration d’éléments interactifs ou visuels.

De plus, se pose le problème critique de la désynchronisation technique. Que se passe-t-il si votre convertisseur HTML > Markdown « casse » sur certaines pages ? Un référenceur va monitorer l’affichage visuel de son site, mais qui va vérifier quotidiennement le rendu .md brut ? Si la transformation est défectueuse, le bot lira un contenu dégradé, ce qui impactera inévitablement votre visibilité dans les réponses génératives.

Le syndrome AMP et la charge de crawl

Rappelez-vous d’AMP (Accelerated Mobile Pages). Nous avons passé des années à maintenir des versions alternatives de nos pages, pour finalement voir l’initiative abandonnée.

Créer des fichiers .md dédiés (ou des chemins alternatifs) ramène exactement le même cauchemar d’infrastructure : l’explosion du budget de crawl.

Comme l’a souligné l’expert Glenn Gabe : « Vous voulez vraiment doubler la charge de crawl ? » Demander aux bots de crawler des millions d’URL supplémentaires pour récupérer une version « texte brut » d’une page qu’ils ont déjà explorée en HTML est une aberration écologique et technique.

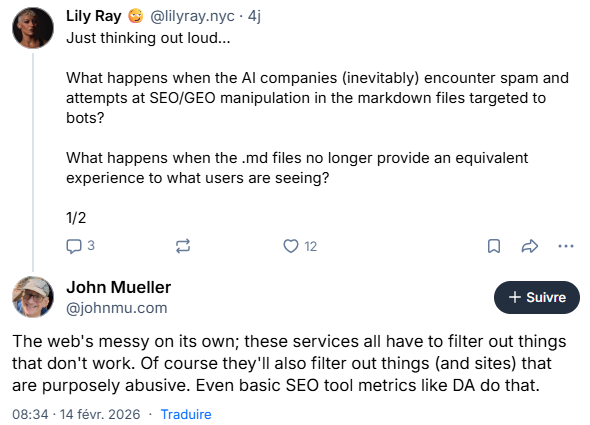

John Mueller (Google) a d’ailleurs rappelé que le web était déjà assez « désordonné » sans avoir besoin de rajouter des surcouches de fichiers parallèles.

Le HTML moderne se suffit largement à lui-même

L’argument de Cloudflare selon lequel le HTML est « trop lourd » pour les IA est valable pour la facture d’API des développeurs de LLM, mais ce n’est pas le problème des éditeurs de sites.

Les moteurs de recherche ont passé plus de deux décennies à perfectionner leurs extracteurs de contenu (DOM parsers). Ils sont aujourd’hui parfaitement capables de nettoyer le boilerplate (menus, footers, scripts) pour isoler le contenu principal.

De plus, en « aplatissant » votre contenu en Markdown, vous sacrifiez une richesse sémantique que les bots adorent :

- Le balisage Schema.org (JSON-LD) : Il est fondamental pour le Knowledge Graph des moteurs de recherche et la compréhension des entités.

- Les balises sémantiques HTML5 : (

<article>,<aside>,<nav>,<main>) qui structurent le sens global de la page.

Conclusion : Que faire pour le GEO à la place ?

Plutôt que de céder à la panique et de déployer des stratégies de « Markdown for bots », la véritable optimisation pour les moteurs génératifs consiste à revenir aux fondamentaux :

- Rédigez un HTML sémantique irréprochable : Une hiérarchie de titres (

H1>H2>H3) logique, des tableaux HTML propres (les LLMs adorent extraire des datas de balises<table>) et des listes à puces claires. - Misez tout sur les Entités : L’IA comprend le web sous forme de graphes. Utilisez le JSON-LD au maximum pour lier votre contenu à des entités connues.

- Répondez directement aux questions : Placez des résumés concis en haut de page. C’est le format idéal pour être repris en snippet ou en citation par une IA (les fameux AI Overviews).

Ne gênez pas le travail des bots en dégradant votre architecture. Votre métier est de fournir le meilleur contenu dans le standard absolu du web : un HTML rapide, accessible et sémantiquement riche.

Et si Deepseek / OpenAI ou Mistral AI ont encore du mal avec le HMTL/JS/Css, ne vous inquiétez pas, ils travaillent d’arrache pied pour rattraper leur retard sur Bing et Google. C’est à eux de s’adapter au web, pas à vous de créer un web bis parce que leur techno de grounding est encore un peu pourrie…

Bibliographie et Sources

- Google & Bing: Markdown Files Messy & Causes More Crawl Load (Search Engine Roundtable, Février 2026) :

https://www.seroundtable.com/google-bing-markdown-files-40928.html - Introducing Markdown for Agents (The Cloudflare Blog, Février 2026) :

[https://blog.