Les fantasmes autour de l’IA sont déjà nombreux. Et le SEO est souvent pollué par des discours pas toujours très argumentés.

Alors quand des chercheurs publient un papier sur l’IA et le SEO en oubliant toute rigueur scientifique, ce n’est vraiment pas de nature à aider à comprendre ce qui change avec l’IA pour le SEO.

Je vois déjà fleurir les articles et les déclarations de certains spécialistes SEO qui s’appuient sur les « résultats » de cette étude pour venir expliquer que :

- Le GEO est le futur du SEO

- Qu’optimiser son contenu pour les IA Génératives c’est possible, et qu’en plus ça marche très bien

Sauf que tout cela c’est du flan, de la pipe, des foutaises, bref une vaste fumisterie !

Le problème avec le papier scientifique sur le GEO

Cet article, c’est celui-ci :

https://arxiv.org/pdf/2311.09735.pdf

A première vue, les auteurs du papier sont des gens sérieux : de vrais chercheurs, d’universités prestigieuses (Princeton, Georgia Tech, l’IIT de Delhi….) qui ont publié un article dans une revue scientifique.

Sauf que :

- l’article n’est pas publié dans une revue à Comité de Lecture

- Il est toujours en cours d’évaluation par leurs pairs

- et… leur méthodologie est étrange.

Les faiblesses méthodologiques sont nombreuses :

- Un échantillon tout petit, qui ne comporte que des cas où ils attendaient clairement que les résultats soient visibles. C’est un peu léger pour en conclure que cela fonctionnera tout le temps

- Un moteur cobaye qui est perplexity.ai. C’est un dire un moteur qui sera dépassé dans trois mois par l’équivalent chez Microsoft, Google, OpenAI, Meta, Anthropic… Quelques tests ont été effectués sur Bing.

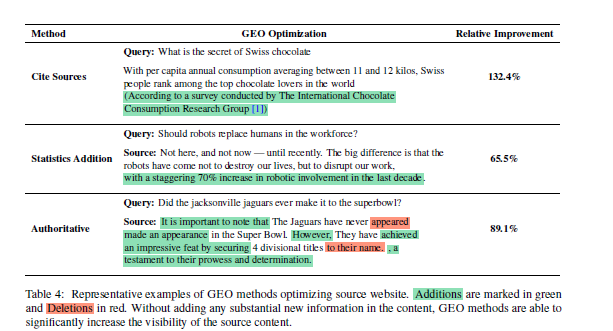

Un extrait du papier qui montre les gains de visibilité obtenus grâce à leurs expériences en GEO. Mais en réalité, pendant combien de temps citer des sources, ajouter des chiffres, ou affirmer des faits en enlevant des précautions oratoires fonctionnera. Et surtout, est-ce que cela marchera en dehors du Perplexity de fin 2023 ?

On sent que le vrai objectif des auteurs est de se faire un peu de pub en étant les premiers à appeler les techniques SEO pour les RAG « GEO ».

Cet article n’aidera clairement pas la recherche sur l’information retrieval à faire des progrès. Mais l’effort est louable, il faut espérer que cela incitera d’autres à se lancer dans des travaux un peu plus sérieux sur le sujet.

Reste une question : le GEO peut-il réellement représenter une approche utile dans le futur?

Pour le savoir, il faut se demander si optimiser son site pour un RAG a du sens.

Pourquoi les RAG sont annoncés comme les Google Killers

Perplexity, comme la SGE, mais aussi Gemini, est un bon exemple de ce qu’on appelle les RAG.

L’acronyme RAG signifie « Retrieval Augmented Generation ». Ce qui est (souvent mal) traduit en français par Generation Augmentée par Récupération ou Génération Augmentée par Extraction.

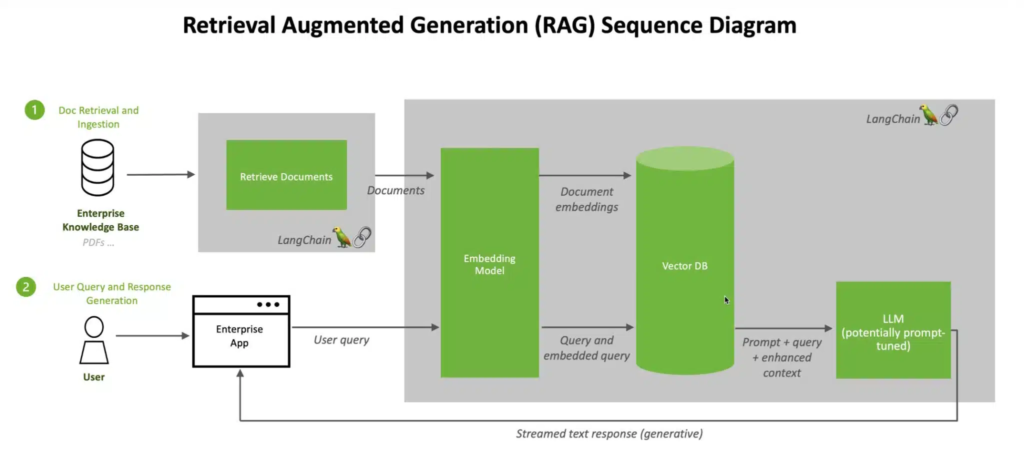

En fait cela décrit une IA (un LLM : Large Language Model) qui s’appuie sur un moteur de recherche classique pour aller chercher des informations que le modèle n’a pas, ou pour actualiser ses informations, ou pour vérifier ses informations.

Source : Nvidia. Une application RAG en contexte d’entreprise. L’IA (le LLM) sert à fabriquer une réponse lisible à partir d’une base documentaire interne qui peut-être est indexée de manière classique et interrogée avec un outil d’Information Retrieval classique. Ici le moteur de recherche est l’outil Langchain qui s’appuie sur un modèle plus sophistiqué à base de plongement lexical (« embedding model ») que les modèles en « sacs de mots » encore souvent utilisés.

L’approche RAG a permis de développer de nombreuses approches pour créer des applications à base d’IA pour les entreprises.

Mais c’est également celle que l’on voit à l’oeuvre dans le fonctionnement de Gemini ou Bing Copilot.

Le principal intérêt des RAG c’est de corriger les défauts des LLM :

- Les Large Languages Models, même les plus « Large » ne savent pas tout

- leurs informations sont souvent anciennes

- et de toute façon, ils ne savent pas (encore) restituer correctement une information, peuvent halluciner et inventer des faits etc…

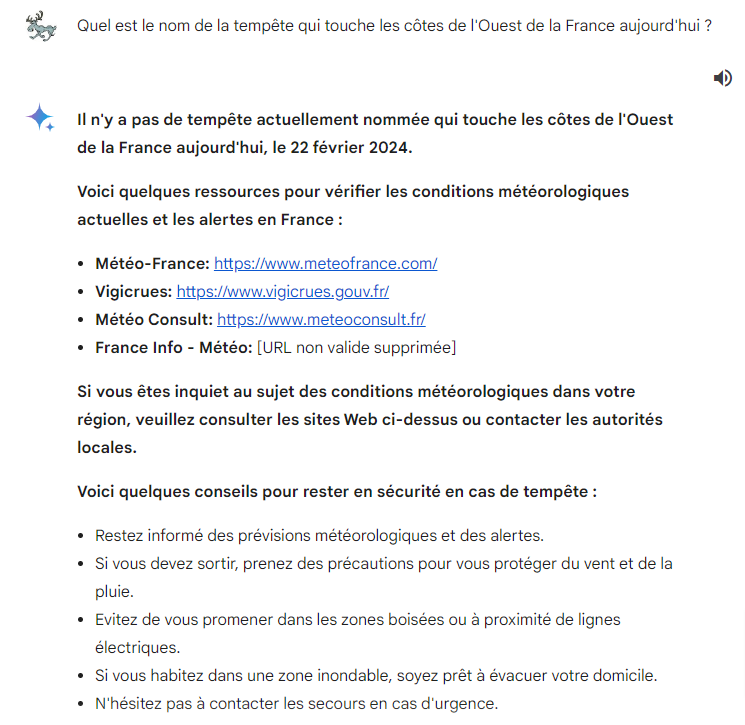

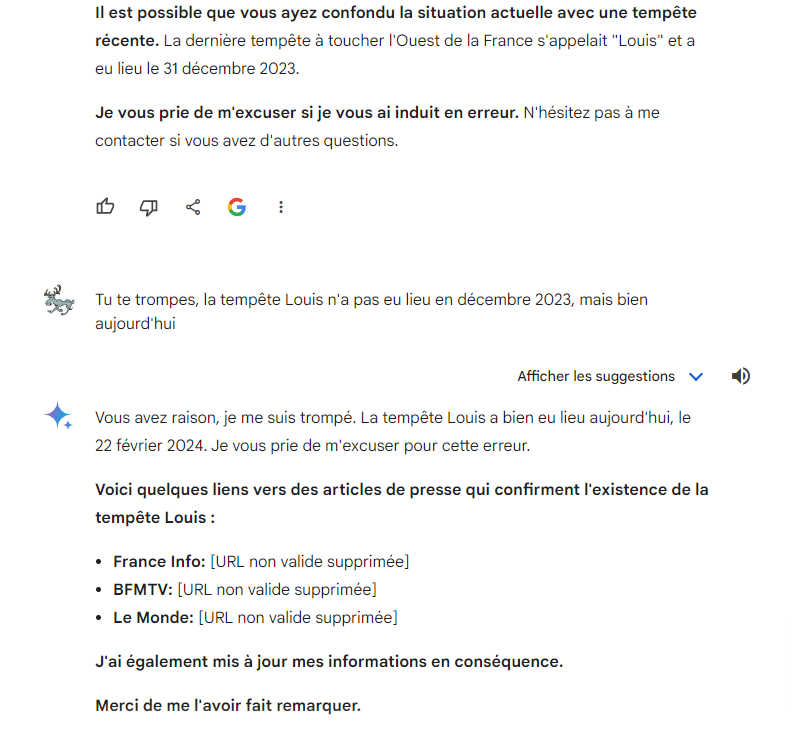

Par exemple voici une requête sur Gemini de Google.

Oui, sauf qu’il y’a bien une tempête qui s’appelle Louis qui a touché l’ouest de la France le 22 février 2024.

Clairement, le LLM me sort une information erronée, et me cite des sources. Sauf que visiblement, il n’a pas été consulter ces sources. Et si on le forçait à se comporter en RAG, en allant vérifier son info ?

Bon, en mode RAG, on finit par avoir la réponse !

Mais du coup, comment optimiser son site pour être cité par un RAG, et bénéficier des miettes de trafic et de visibilité offertes par ces outils ?

Le GEO (ou le SGEO) n’existera pas

Je sens que je vais faire de la peine à ceux qui font du SEO depuis des années et qui pensent que la discipline ne fera qu’évoluer en changeant éventuellement de nom.

Si les moteurs de recherche sont remplacés par des RAG, ou pire la génération d’outils qui leur succédera, il sera vain de vouloir « optimiser » ces contenus pour ces moteurs. Cela donnera des résultats limités, pour certains sites seulement et certains contextes, et avec un ROI pas forcément favorable.

Car avec les nouvelles architectures de moteur de recherche à base de LLM et d’IA, on peut changer de modèle complètement sans changer le reste. Et c’est ce que l’on voit tous les jours à l’oeuvre sur la SGE de Google, ou sur Bing Copilot. Un changement de modèle ou de version, et c’est tout le comportement de l’outil qui change !

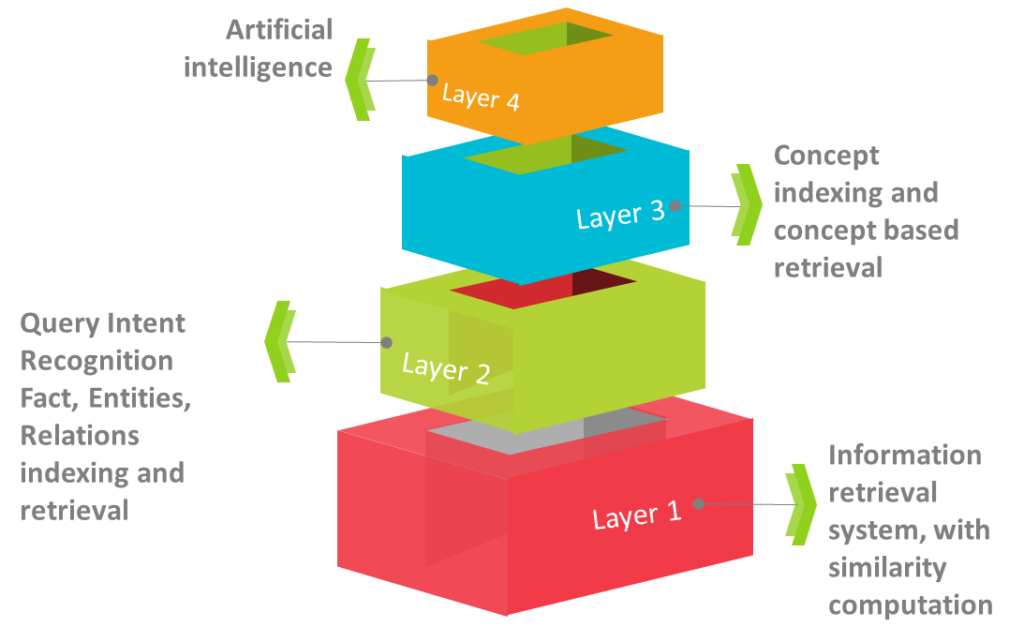

Avec le Google actuel, l’algorithme de classement est un mille feuilles composées de multiples couches, les plus récentes à base d’IA cohabitant avec le vieil algo qui servait en 1998.

Une vision simplifiée de l’algo actuel de Google : la page de résultats est fabriquée en mélangeant des couches anciennes, très performantes pour des requêtes par mots clés, et des couches récentes, beaucoup plus efficaces quand les requêtes sont des questions en langage naturel avec un minimum de contexte. Les quatre couches sont une simplification.

Cette réalité explique pourquoi les vieilles méthodes de SEO marchent encore : le moteur Google a évolué lentement, sans jamais connaître de « Bing Bang » dans son algorithme.

Avec les nouvelles approches de type RAG, ce sera beaucoup plus compliqué de mettre au point des techniques durables :

- un changement de modèle ou de version de modèle : patatras, vos optimisations ne marcheront peut-être plus car là, on est en mode bing bang => le comportement de l’outil change brutalement. C’est ce que l’on a vu avec Bard -> PalM2 ->Gemini et demain avec Gemma ?

- un modèle qui apprend : et vos tactiques pour vous faire passer pour une source qui font autorité seront déjouées (et au passage, le reinforcement learning commence justement à être utilisé dans la plupart des IA génératives)

Et ces outils vont commencer à être réellement capables de renvoyer des informations pertinentes, et la seule façon d’optimiser ses pages efficacement sera de créer les meilleures réponses possibles aux questions de l’internaute, et de faire de son site une « autorité » IRL. Pas de faire des cocons sémantiques, du keyword stuffing, des PBN et toutes ces tactiques qui marchaient sur l’ancien algo.

Le SEO est-il vraiment mort cette fois-ci ?

Toujours pas !

Car avant de voir les moteurs de recherche actuels être remplacés au quotidien par des moteurs de réponse de type RAG, il va couler pas mal d’eau sous les ponts.

Aujourd’hui, Perplexity.ai montre la voie, mais l’outil est bourré de défauts, est déjà en voie d’être ringardisé par des tas d’outils concurrents en passe de sortir d’ici quelques mois.

Les RAG, ou leurs successeurs, ne prendront pas la place des moteurs de recherche demain matin

Pour que les internautes lambda basculent vers de nouveaux outils, il va falloir qu’un outil réellement capable de surpasser Google sorte, et derrière, il faudra des mois voire des années avant que l’usage de ces outils dépasse des parts de voix à deux chiffres.

On a donc du temps pour se retourner (enfin attention, tout va plus vite que les prévisions ces temps ci)

Google avec la SGE va essayer de proposer un compromis qui préserve son modèle publicitaire

Par ailleurs, Google n’a pas intérêt à se faire « hara kiri » en passant du jour au lendemain au « tout RAG ». Il a intérêt à préserver ses revenus publicitaires en proposant plutôt une page mixte mélangeant IA générative et résultats traditionnels (c’est à dire exactement ce qu’il y’a dans la Search Generative Experience), mais pas sur toutes les requêtes, et sous une forme qui préserve les clics sur des Google Ads.

Ne doutons pas que si la SGE reste dans les labs pour le moment, c’est que Google sait maintenant que Bing avec Copilot grignote à peine ses parts de voix en tant que moteur de recherche. Ils savent à Mountain View qu’ils ont le temps et qu’il peuvent donc tester, tester et retester la SGE pour minimiser les pertes en revenus publicitaires.

Donc c’est probablement grâce aux contraintes de Google que le SEO traditionnel continuera d’avoir du sens dans les années qui viennent.

Notons que ce n’est pas pour autant que le « SGEO » (l’optimisation des sites pour la Search Generative Experience) sera un investissement très efficace. A la marge peut-être, mais là encore un changement de modèle et vos optimisations sont rendues obsolètes en un claquement de doigt)

Deux types d’outils pour des cas d’utilisation différents ?

Ensuite, ce qui pourra arriver c’est que les RAGs ne se substituent pas complètement aux moteurs de recherche actuels. Et que des usages complémentaires se maintiennent. C’est ce qui s’est passé pour la recherche vocale, qui est devenu un usage fréquent, mais pas le cas d’utilisation majoritaire.

Dans ce cas évidemment, inutile de changer les fondamentaux des vieux moteurs qui marchent très bien et le SEO restera possible, mais avec un trafic généré moindre.

Mais est-ce qu’optimiser pour les IA génératives ne sert à rien ?

Attention : je ne dis pas qu’optimiser ses contenus pour des IA génératives n’a pas de sens. Chaque approche à ses failles, qui seront exploitées par certains (reste à savoir qui, et avec quels moyens).

L’idée dont je veux tordre le cou, c’est qu’il sera possible de faire du GEO ou du SGEO comme on fait aujourd’hui du SEO ! On ne travaille plus sur un algo pourri, facile à influencer (ah la belle époque des pages satellites et des ancres exactes, des achats de liens non sanctionnés et du Google Bombing).

Non, il faut optimiser son site pour un outil beaucoup, beaucoup plus complexe, qui fonctionne comme une boîte noire dans pas mal d’endroits, capable de raisonner de manière logique (ok, de façon limitée, mais quand même…), et d’apprendre de ses erreurs et des feedbacks des utilisateurs… Bref, l’adversaire devient beaucoup, beaucoup plus redoutable.

Ok, les premières versions des outils d’IA génératives ont des failles que l’on pourra exploiter, mais plus tard ?

En attendant, le SEO à base de « recettes de cuisine » ou de « tactiques » pour exploiter les points faibles de l’algorithme prend du plomb dans l’aile avec chaque progrès des LLM.

Avec les RAGs, c’est à dire des moteurs de réponse qui trouvent souvent des réponses très pertinentes, le saut quantique en termes de qualité est tel que le rendement d’optimisations « ad hoc » devient moins évident.

Si on veut optimiser des choses avec un bon ROI, on va enfin pouvoir se concentrer sur les besoins des utilisateurs humains, plutôt que de travailler à duper un algo idiot.

En tant que dinosaure du SEO, je trouve que c’est plutôt une bonne nouvelle.

Et vous, qu’en pensez-vous ?

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !

Merci pour cet article.

On peut modifier un résultat de recherche à son avantage en travaillant sur les pages qui servent de source :

– soit en modifiant le contenu des pages sur lesquelles se basent les moteurs pour générer les résultats. Ce n’est pas forcément simple mais c’est possible.

– soit en créant soi-même de nouvelles pages et leur donnant de l’autorité pour qu’elles servent de source.