La firme de Mountain View avait clairement été piquée au vif par la sortie de ChatGPT il y’a un an, et par sa rapide intégration sur Bing, ainsi que par l’intégration rapide de l’IA dans les produits Microsoft.

C’est vrai que jusqu’en 2022, Google avait largement démontré une certaine avance technologique sur les modèles de langage préentrainés. Ses chercheurs sont en plus à l’origine de la plupart des concepts qui ont permis d’en arriver aux Large Language Models d’aujourd’hui.

Le projet Gemini est donc né de cette prise de conscience en interne de la nécessité de sortir rapidement quelque chose de plus avancé. Le premier LLM utilisé pour Bard était un cran en dessous des possibilités de GPT4. Il a depuis été remplacé par PaLM2, qui est un LLM plus à même de restituer correctement des connaissances ou de fonctionner à base de règles que les outils GPT d’OpenAI. Mais ce n’était pas suffisant selon Google.

Sundar Pichai a donc décidé en avril 2023 de fusionner les équipes de l’entreprise Deepmind et ses équipes internes travaillant sur l’IA. Deepmind est à présent le nom du département qui produit les outils d’IA chez Google, ce n’est plus une entreprise différente.

Et Deepmind, depuis le printemps dernier, travaille sur deux projets :

- MAGI : un outil de recherche à base d’IA, capable de « disrupter » les moteurs de recherche traditionnels (dont Google Search). La SGE n’en est probablement à son dernier stade de développpement aujourd’hui

- et Gemini, une IA multimodale avancée

Gemini : une avancée spectaculaire

Si Google voulait avoir son moment « Wow », cette fois-ci c’est réussi. Rien à voir avec le lancement calamiteux de Bard au début de l’année.

Le lancement a néanmoins été repoussé de quelques jours, et sous une forme moins risquée qu’une conférence de presse où l' »effet demo » aurait pu produire un nouveau bad buzz.

Voici la principale video de démo publiée par Google Deepmind :

En terme de performances pures, Gemini n’a pas l’air de faire des choses incroyables par rapport à certains outils d’IA spécialisés. Mais ce qui frappe, c’est la fluidité et la rapidité de l’intéraction avec l’outil qui prend n’importe quel format d’information en entrée pour produire un résultat également multimodal, et ceci sans prompts compliqués.

Quelques caractéristiques innovantes de Gemini

Gemini est un outil « nativement » multimodal. Jusqu’ici, les outils « à la ChatGPT-4V » fonctionnaient comme un assemblage de fonctionnalités pour arriver à gérer un mode conversationnel comme la possibilité de manipuler les images ou les sons ou les videos.

Mais surtout, Gemini 1.0 embarque des capacités de raisonnement multimodales. Cela signifie que l’outil est capable de donner un sens à des données visuelles complexes, comme un dessin, une série de points, et en déduire de nouvelles informations. Les LLMs classiques en sont incapables aujourd’hui.

Gemini 1.0 a été entrainé également pour comprendre des contenus complexes ayant trait aux mathématiques ou à la physique.

Et l’outil est également capable de comprendre, expliquer et générer du code de bonne qualité en Python, Javan C++ et GO. Une nouvelle version d’Alphacode : Alphacode 2, a été réalisée grâce à une version spécialisée de Gemini.

Des performances impressionnantes sur les principaux benchmarks IA

Les principaux développeurs d’IA et de LLM annoncent à chaque lancement qu’ils ont créé l’outil avec le plus de paramètres, et les plus performants sur leurs tâches. Mais évidemment, personne n’est obligé de les croire.

Les chercheurs en IA ont donc établi quelques outils pour passer au banc d’essai les IA et obtenir des résultats normalisés.

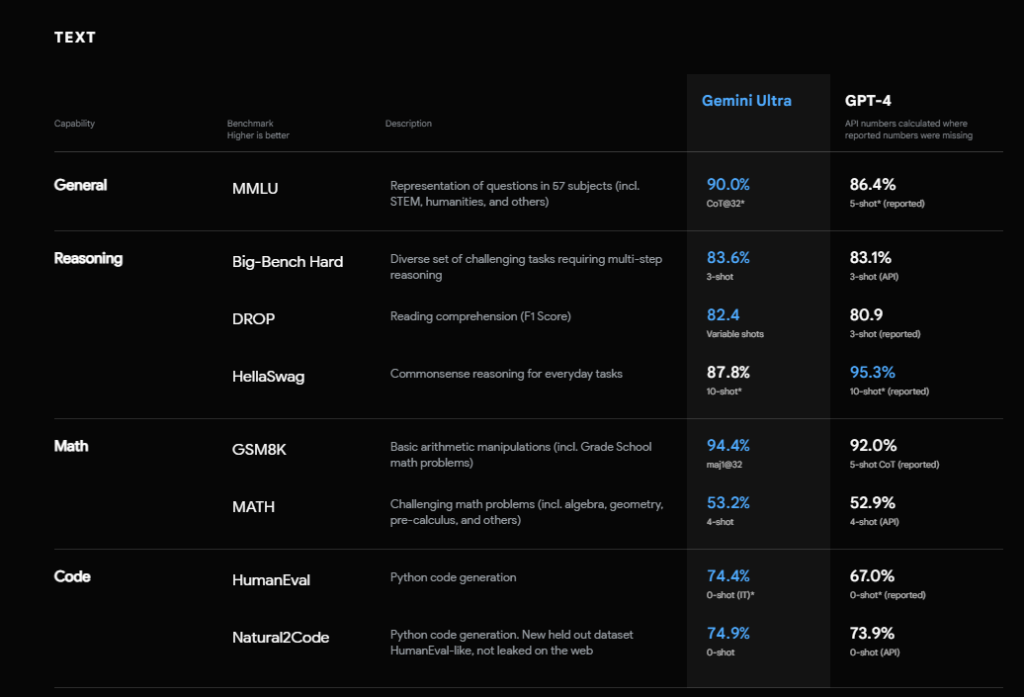

Voici les résultats de Gemini sur les tests de manipulation des textes :

Pas de « saut quantique » en terme de performance sur les tâches autour des textes, mais une amélioration sensible.

Le résultat sur le test MMLU est intéressant, car il démontre que l’outil Gemini atteint les résultats d’un spécialiste humain dorénavant quand on lui des questions sur les sciences dures ou sociales ou des questions de culture générale.

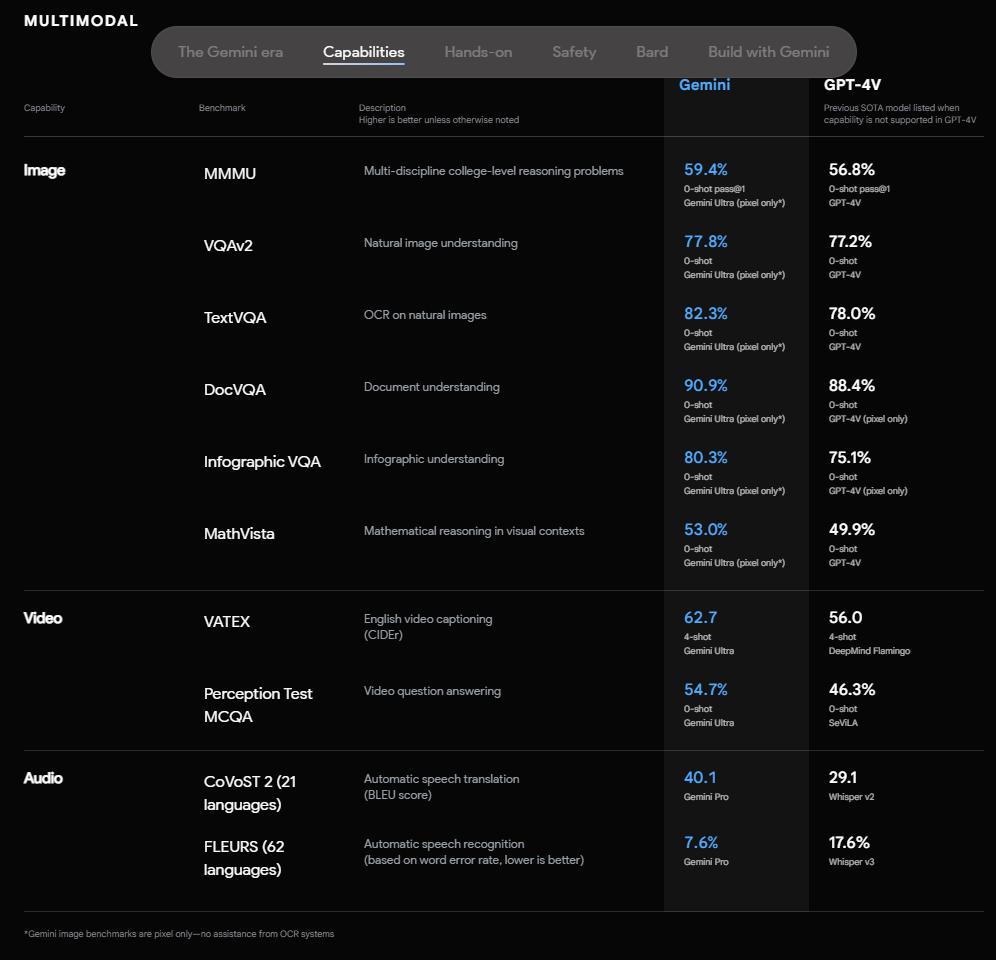

Sur les tests multimodaux, les résultats sont également meilleurs que la plupart des concurrents.

Ou peut-on tester Gemini ?

Gemini 1.0 sera déclinée sous différentes versions, embarquées dans certains produits de Google.

La version Nano est une version compacte du modèle, qui sera déployée dans Android 14 à partir des appareils Pixel 8 pro.

La version Pro sera accessible à partir du 13 décembre via une API disponible sur Google AI Studio ou Google Cloud Vertex AI.

Depuis hier (le 6 décembre), Bard n’utilise plus PaLM 2 mais une version affinée de Gemini Pro. Pour le moment, cela ne fonctionne que pour l’anglais, mais sur 170 pays et territoires.

Gemini est également testé dans Google Search via la Search Generative Experience (toujours en bêta). Pour le moment le principal apport de Gemini est de permettre de répondre plus rapidement aux questions des internautes.

Quand à Gemini Ultra, il n’est pas encore disponible, et est encore en période de test. Aucune date n’a été annoncée pour son déploiement. Il sera intégré dans Bard Advanced début 204, la version survitaminée de Bard

Une première version sortie pour reprendre le leadership?

Cette version 1.0 de Gemini n’est probablement pas celle qui changera la donne. Mais c’est la première fois depuis un an que Google sort quelque chose qui ringardise les produits d’Open AI, de Meta ou d’Anthropic.

On sent en même temps que Google a voulu montrer quelque chose rapidement, plutôt que d’attendre que le modèle Ultra soit entièrement disponible.

Les prochaines semaines risquent d’être intéressantes, car Google a visiblement encore de nouvelles choses à sortir bientôt, et la concurrence se doit maintenant de réagir.

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !