Nous avions déjà évoqué l’initiative de Google pour remplacer le robots.txt par autre chose afin de piloter quels contenus peuvent être accessibles aux outils d’IA.

Il semble que les équipes de Google n’aient pas voulu attendre la fin des discussions en cours avec les principaux acteurs de l’écosystème pour lancer une solution se basant sur l’actuel standard : le robots.txt

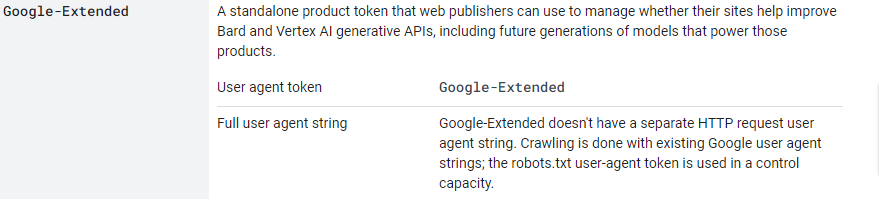

Google vient d’annoncer la création d’un nouvel user agent : Google Extended.

Son objectif est clairement de permettre d’indiquer aux outils de Google qui collectent des données pour des usages IA quels sont les contenus dont le propriétaire du site autorise l’exploitation pour ces usages.

Si vous ne souhaitez pas que vos contenus soient exploités par l’IA générative Bard ou Vertex AI ou les futurs produits Google AI, vous pouvez ajouter un block « Google-Extended » dans votre robots.txt

Ce user-agent fonctionne un peu comme pour celui de Google News (Googlebot-News) : si vous regardez vos logs, vous ne verrez jamais de « hits » avec ce user-agent. Les contenus destinés aux outils d’IA de Google sont téléchargés avec un user-agent de type « Googlebot », ces contenus sont ensuite placés dans un repository pour être réutilisés par différents outils, dont les outils d’IA. C’est la réutilisation qui est bloquée par les directives disallow pour ce bloc, pas le téléchargement.

La liste des user agents de Google ne cesse de s’allonger, la gestion du robots.txt tend vraiment à se complexifier.

Côté Bing, ils viennent d’annoncer il y’a quelque jours une solution moins propriétaire : si vous voulez indiquer que vos contenus ne doivent pas être exploités par les outils d’IA de Bing, alors il vous suffit d’ajouter un attribut nocache ou noarchive dans la balise meta robots ou x-robots-tag.

- sans attribut nocache ou noarchive => votre contenu pourra apparaître dans les réponses de Bing Chat

- avec nocache => votre contenu pourra apparaître, mais seuls les balises <title>, l’url et les snippets extraits pour Bing Search pourront servir à entrainer les IA de Bing

- avec noarchive => votre contenu sera marqué comme non utilisable par les outils d’IA

- noarchive et nocache combinés sont interprétés comme nocache

Et vous, quelle solution vous semble la plus appropriée ? Celle de Google, ou celle de Bing ? N’hésitez pas à le dire dans les commentaires.

L’annonce de Google :

https://blog.google/technology/ai/an-update-on-web-publisher-controls/

Plus d’infos sur les user-agents de Google :

https://developers.google.com/search/docs/crawling-indexing/overview-google-crawlers

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !