J’ai eu l’occasion de participer à une table ronde le 9 septembre dernier à l’occasion du « Grand Est Numérique » à Metz, avec Zohra Belmahdi de Textbroker, Olivier Andrieu d’Abondance, et Vincent Schneider d’Idée Ad.

La thématique ? 10 ans de SEO – rétrospective 2012-2022

Cela m’a donné l’idée de partager avec vous un certain nombre de constats (parmi tous ceux évoqués lors de la table ronde) sur ces dix dernières années, aussi bien sur l’évolution de l’entreprise Google, sur son algorithme, mais aussi sur le métier.

J’ai choisi quelques éléments de réflexion qui me paraissaient importants de mentionner, mais si vous souhaitez débattre d’autre sujets et présenter votre point de vue, n’hésitez pas à commenter.

Google a développé son business en dix ans, mais son image n’est plus ce qu’elle était

En 2012, beaucoup croyaient encore dans la baseline de Google : don’t be evil !

Mais en 2022, la liste des reproches sérieux adressés à la firme de Mountain View ne cesse de progresser.

Dès 2012, le filtre Panda n’a pas ciblé que les fermes de contenu. Google en a profité pour faire disparaître de la tête des résultats un certain nombre de ses concurrents sur son modèle publicitaire. Cela a donné lieu à plusieurs recours. Certains n’ont pas abouti, d’autres ont conduit après des années à des amendes record.

En 2022, Google s’est fait rappeler à l’ordre sur de nombreux sujets, par les autorités européennes, mais aussi américaines :

- des violations du RGPD

- des abus de position dominante

- des manoeuvres anticoncurrentielles

Et on parle maintenant de procédures pouvant aboutir au démantèlement d’Alphabet.

Cette évolution n’est pas spécifique à Google, elle concerne tous les GAFAM.

L’image de ces entreprises est écornée, les autorités commencent à prendre la mesure des problèmes qu’elles posent, mais pour le moment rien n’a véritablement empêché les GAFAM de monter en puissance et de faire des profits record !

Mais en tout cas, le camp des naïfs qui croyaient que Google construisait un monde meilleur est devenu beaucoup plus restreint !

Par contre, le nombre des gens que Google fait vivre, ou qui dépendent du moteur de recherche a lui cru considérablement… Je me compte parmi eux. Depuis vingt ans, plus de 90% de mes revenus viennent indirectement de l’existence de Google.

Le web a bien changé, Google s’est adapté

En dix ans, le web a connu une profonde mutation.

Les réseaux sociaux ont explosé, se sont diversifiés et ont pris une place importante dans l’écosystème, en termes d’audience et en terme de revenus. Sur ce sujet, Google s’est sérieusement planté : Google + a fait un flop, et les autres tentatives n’ont pas été réellement probantes.

Le web mobile a apporté la principale révolution : aujourd’hui, les consultations de pages web sur mobile sont devenus l’usage dominant. Il a fallu que Google passe au « mobile first index », ils l’ont fait avec retard, et cela pris de très nombreux mois pour basculer la très grande majorité des sites dans ce mode (ce n’est même pas fait pour 100% des sites aujourd’hui !). On peut faire le même constat sur l’adaptation de leur algorithme aux usages mobiles : ils l’ont fait lentement, avec prudence et plus tard que tôt !

Google a essayé de promouvoir différentes solutions techniques qui ont toutes fini par devenir obsolètes : l’app indexing, les pages AMP, le PWAMP !

(oui pour ceux qui ne l’auraient pas encore compris, l’AMP n’a plus d’avenir, ne prévoyez plus de gros projets autour de l’AMP !)

La façon de développer des sites a considérablement changé également :

- les frameworks JS sont utilisés par de nombreux sites aujourd’hui

- les services cloud sont de plus en plus employés

- de nouvelles architectures logicielles se sont développées : les sites « headless », les sites statiques, les « progressive web apps »

- le low code / no code est à la mode

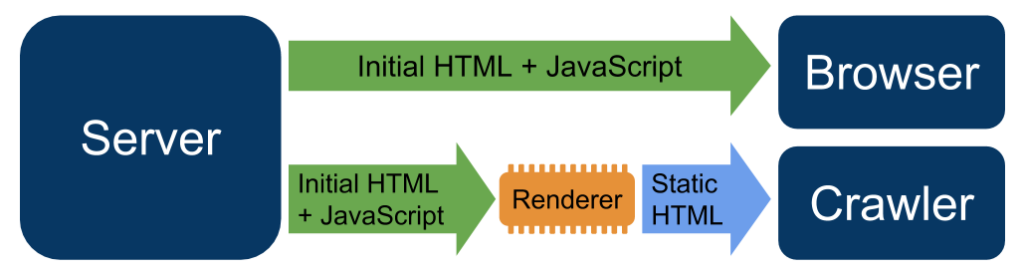

Google s’est donc lancé, cette fois-ci dans les premiers, dans l’indexation des sites dont le code HTML était généré en javascript dans le navigateur.

Aujourd’hui cela fonctionne plutôt bien, à condition que le code de ces sites d’un genre nouveau soit bien fait. Ce qui n’est pas toujours le cas. Dans certains cas, on a même assisté à des régressions : c’est vrai sur les performances web, qui en moyenne se sont dégradées en dix ans, alors que tout est censé être plus rapides : les machines, les tuyaux, les serveurs…

Le SEO technique a beaucoup changé, mais il reste plus que jamais d’actualité

Quand on parlait de SEO technique en 2012, on pensait à l’analyse de logs, aux crawls, et au maillage interne, ainsi qu’à la résolution des problèmes posés par des CMS qui se prétendaient « SEO friendly » mais ne l’étaient pas.

En 2022, le SEO technique c’est beaucoup, beaucoup plus de sujets, demandant beaucoup plus d’expertise :

- résoudre des problèmes de performance

- gérer les problèmes de données structurées

- rendre des architectures nouvelles compatibles SEO : PWA, sites headless, sites fait avec des frameworks JS, sites dans le cloud…

- gérer des problèmes d’explorabilité, de canonical, de hreflang, d’indexation

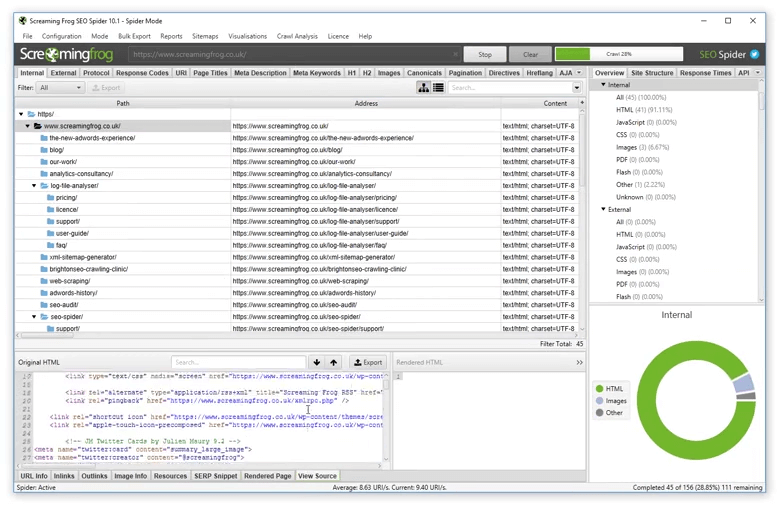

La principale différence depuis 2012, c’est l’arrivée de nouveaux outils sur le marché qui ont simplifié le travail d’analyse : Botify, Oncrawl, Semrush, mais aussi et surtout Screaming Frog, qui a démocratisé les analyses à base de crawl.

Aujourd’hui, le travail de SEO technique est plus tourné sur la problématique de l’implémentation. Et c’est une très bonne chose. Même si cela signifie qu’une partie des « experts SEO » n’est pas capable de le faire.

La production de contenu SEO évolue, mais la prise de conscience a été tardive en France

Le « content marketing » est une approche qui s’est développée aux US dès 2012 (après l’électrochoc Panda). En France on continue à produire du contenu en utilisant des recettes de cuisine qui datent d’avant 2012 :

- du contenu produit en masse, de qualité insuffisante pour les utilisateurs (mais on le montre aux moteurs de recherche parce que c’est important de capter le trafic)

- « optimisé pour le SEO » => c’est à dire en suivant des règles définies entre 2000 et 2010, parfois totalement obsolètes depuis dix ans (ah la « triplette du bourrin », les « cocons sémantiques » mal fichus, le « content spinning » horrible, les textes SEO collapsés dans les pages…)

Panda n’a pas servi de leçon à tout le monde, loin de là. Le ménage sur les requêtes YMYL en a forcé plus d’un à changer de stratégie, mais dans le même temps beaucoup n’ont pas compris pourquoi ils se faisaient « dézinguer » par les quality updates ou les broad core updates successives.

Les réflexions plus poussées sur le contenu prennent un peu de place depuis 3 à 5 ans, et on commence à comprendre enfin en France que le content marketing peut apporter. Mais c’est loin d’être si répandu que cela.

2012-2022 a montré une grande constance dans la production de contenu SEO de qualité médiocre.

Google semble siffler la fin de la partie avec le HCU. On verra si 2022-2032 sera une période différente sur la production de contenu.

Le netlinking: toujours clé, mais c’est plus dur de tricher

Google a fortement progressé sur la détection et l’annulation de l’impact des liens manipulés. On est passé en dix ans d’un process manuel, avec des pénalités « pour l’exemple », à quelque chose de plus efficace, mais aussi beaucoup plus silencieux.

Peut-on encore tromper l’algo en se faisant pour plus « populaire » qu’on l’est vraiment ? Oui. Le link building est toujours aussi clé pour avoir une bonne visibilité sur les pages de résultats.

Par contre, beaucoup de propriétaires de site qui achètent des liens vers les plateformes sont souvent démunis pour savoir si ces liens acquis à prix d’or leur apportent quelque chose ou pas.

La dernière décennie a vu le développement d’outils pour le SEO. Mais parmi ces outils, je ne mettrai pas les plateformes de netlinking sur le même plan qu’un outil comme Screaming Frog. Si certaines font un travail correct, la plupart des plateforme aident des revendeurs à vendre des liens pourris qui n’apportent rien. On frise souvent le délit de tromperie, parfois carrément l’escroquerie. Mais personne ne se plaint donc la production de sites artificiels, de PBN, de webspam pour le linkbuilding se développe de manière anarchique.

En dix ans, l’économie grise autour du netlinking s’est fortement développée. Un écosystème d’outils s’est renforcé, parfois avec des pratiques qui diminuent la crédibilité du SEO et n’en donnent pas une image professionnelle.

En dix ans, le SEO est devenu la raison majeure pour lesquelles certains hackent des sites. Ce n’est pas glorieux.

Le savoir en SEO est devenu mainstream, mais ce n’est pas le bon savoir…

Le SEO est devenu « mainstream », et il est devenu plus facile d’apprendre à optimiser des sites.

Dans les années 2000, il n’était pas rare de voir des « experts » en SEO protéger leur savoir jalousement de peur que des concurrents ne rattrapent leur avance technologique. Cette tendance n’existe que chez les black hat aujourd’hui, mais dans la pratique, la volonté de se faire valoir en montrant à la communauté ce que l’on a trouvé est souvent trop forte et même chez les BH, le partage du savoir est devenu la règle.

Au cours des dix ans écoulés, tout le monde a eu accès au savoir sur le sujet du SEO. Le nombre de livres sur le sujet a explosé, même chose pour les formations, les conférences, les MOOCs, les webinars, les blogs, les sites spécialisés, etc. , etc.

Google a aussi fait des efforts pour communiquer vers les webmasters. Ces efforts sont souvent critiqués, mais il y’a eu clairement des progrès de ce côté.

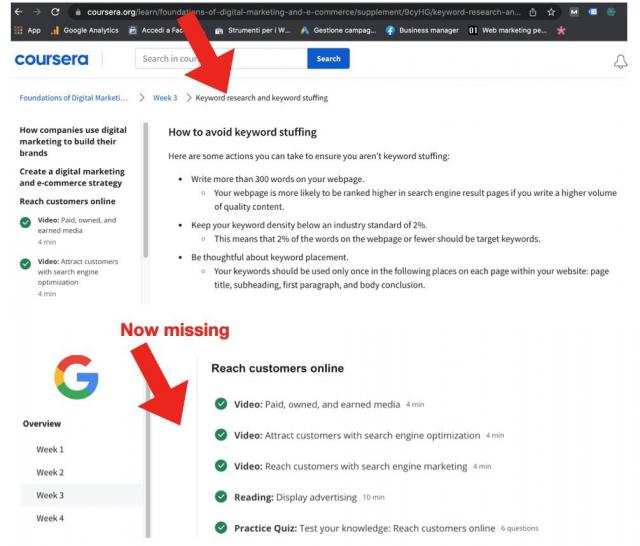

Hélas, il faut constater que la qualité de ce qui est transmis est problématique, sauf exception

- les conseils et recommandations sont souvent obsolètes

- l’obligation de tenir compte du contexte est souvent zappée. On généralise jusqu’à l’absurde : « vos textes doivent faire 1000 caractères au moins » => ah bon ? Même si je dois juste donner une définition ?

- on enseigne des bonnes pratiques, mais sans hiérarchiser ce qui est important et ce qui ne l’est pas pour progresser en visibilité

- on reste dans l’analyse, sans enseigner des méthodologies pour progresser. C’est au mieux du savoir, mais pas du savoir faire

Sur ce plan, en dix ans, la démocratisation du savoir autour du SEO a plus créé un nivellement vers le bas qu’autre chose.

Et ce que l’on voit mis en oeuvre le plus souvent, ce sont des tactiques de 2012, toujours utilisées en 2022. Sauf que Google a bien changé, lui. Et que ces tactiques ne marchent plus, ou sont devenues beaucoup moins efficaces.

Pas de grosses innovations en SEO depuis dix ans…

Mais au delà de ce problème de « mise à jour » des connaissances et des méthodes, qui est bien réel et pas vraiment sympa, il y’a aussi un réel problème d’innovation.

Depuis dix ans, qu’est-ce qui a été inventé de majeur en matière de SEO ?

Pas grand chose. Evidemment, dans les années 2000, il fallait tout inventer : les outils et les méthodes.

Entre 2012 et 2022, on a vu les outils inventés dans les années 2000 s’industrialiser. Mais ces outils appliquent des principes du début du siècle.

Pouvait-on inventer des choses nouvelles ? Probablement.

Mais la réalité, c’est que les agences ont arrêté d’innover en matière de SEO. Les grandes agences digitales ont mis des moyens sur le paid, et les autres canaux digitaux.

Le SEO a souffert d’un grand déficit de moyens consacrés à la recherche et à l’innovation depuis dix ans. Les premiers signes d’un changement de ce côté apparaissent depuis quelques années seulement. De nouvelles approches sont rendues possibles par l’IA et on commence à voir apparaître de réelles nouveautés grâce à cela. Mais en attendant, on voit des innovations dans les outils, mais pas vraiment de nouvelles méthodes de référencement.

C’est aussi en partie dû au fait que, côté algorithme de Google, il y’a eu des évolutions mais pas de révolution.

Google est AI first, sauf sur son moteur de recherche

Dans les évolutions profondes du digital, la montée en puissance de l’IA et de ses applications est une vraie source de disruption dans les années à venir. Google le sait, et a commencé à parler de sa conversion en entreprise « AI First » il y’a plusieurs années déjà. Sauf que l’IA dans son algo est encore assez marginale : le moteur Google n’est pas AI First.

Par contre, de l’IA se niche un peu partout dans le moteur :

- déjà dans le filtre Panda (ou HCU) sous forme d’apprentissage automatique semi supervisé

- dans les modèles de langage utilisés par Google (BERT, MUM) même si cela n’a rien révolutionné encore

- dans la recherche visuelle où par contre les progrès sont réels et bien visibles (notamment avec Google Lens)

- dans la lutte contre le spam avec des classifieurs de plus en plus puissants pour détecter les backlinks à annuler ou les pages à ne pas indexer (par exemple)

- dans la compréhension du langage naturel et dans la recherche vocale

La recherche vocale a déjà eu le temps en quelques années de passer de fonctionnalité de film de science fiction, à une fonctionnalité utilisable au quotidien qu’on présentait comme la future façon de la faire la recherche (cf. la prédiction selon laquelle 50% des requêtes en 2020 allaient passer par la recherche vocale : ce n’est toujours pas vrai en 2022), et pour finir une simple façon différente de faire des requêtes, mais dont l’adoption générale semble ne pas aller de soi.

Google aujourd’hui travaille beaucoup moins la recherche vocale que la recherche visuelle, qui semble concentrer chez eux plus de moyens (cf les annonces du dernier Google I/O)

Le SEO devient exigeant, mais cela ne se reflète pas assez souvent dans les pratiques de la communauté

En conclusion, on peut constater que l’écosystème web comme Google et ses algorithmes ont connu de fortes évolutions depuis dix ans. Est-ce que cela s’est reflété dans les méthodes et les pratiques en SEO ? Pas vraiment. Et c’est regrettable.

La plupart font encore du SEO comme on le préconisait pré Panda (avant 2012) et même souvent les recommandations que l’on trouve ici ou là n’ont plus de sens depuis au moins 2005.

Dans le même temps le travail sur les autres canaux digitaux s’est fortement professionnalisé.

Cette professionnalisation était elle possible aussi pour le secteur du SEO ? Oui, car sur ce point les progrès ont été réels dans des pays voisins (UK, Allemagne) ou aux USA. Chez Neper, on a très vite senti sur nos clients internationaux que sans placer la barre très haut dans la qualité et la pertinence de nos prestations, il allait être difficile de déloger des concurrents étrangers.

En 2022, le SEO pour être efficace est devenu beaucoup plus exigeant. Il faut de la rigueur, savoir analyser des quantités de données devenues pléthoriques, gérer des projets, savoir résoudre des problèmes techniques complexes, être capables de proposer des stratégies de content marketing de haut niveau…

Le temps n’est plus aux quickwins et aux recettes de cuisine. Le SEO est devenu holistique (je le disais en… 2012 au SMX Paris), c’est à dire que pour avoir de bons résultats, il ne suffit plus d’optimiser son site sur un critère, voire deux ou trois, mais sur tous les aspects qui vont démontrer que votre site est digne de figurer en tête des résultats. Et cela demande une approche fondamentalement différente dans la gestion des priorités.

Mais on apprécie beaucoup cette évolution chez Neper, cela rend le travail pour nos clients plus difficile, plus exigeant, mais aussi beaucoup, beaucoup plus gratifiant.

Gratifiant car on sait que ce qu’on obtient ce sont des résultats durables. Et que nos clients ne courent aucun risque de subir une pénalité.

Gratifiant parce que nous pouvons être fiers de ce que l’on fait sur les sites de nos clients. Inutile de masquer des choses, de les camoufler, de faire du cloaking etc.

Gratifiant parce qu’on a aussi l’impression de travailler sur les optimisations pertinentes aujourd’hui et de préparer celles qui le deviendront demain… Et non sur des choses obsolètes depuis dix ans.

Ce serait bien que plus de gens prennent conscience de cette nouvelle donne, et arrêtent de penser que l’histoire du SEO s’est arrêtée en 2010… Ce n’est pas le cas

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !

Il est effectivement plus gratifiant d’enrichir le web que de le polluer.

Excellent retour d’expérience Philippe, merci. Ce n’est pas tous les jours que je lis un article de cette taille dans son entièreté. Réflexions très intéressantes

Merci Philippe pour ce bilan ! Je te rejoins sur tous les points.

J’ai également remarqué que certains SEO, dans la nouvelle génération, arrivent à faire de l’argent avec moins de connaissances techniques qu’au paravent. C’est étrange de mon point de vue étant sur le web depuis le début surtout qu’il n’y a jamais eu, comme tu le dis, autant de transparence et de partage dans la profession.

Bravo Philippe et merci à tes confrères orateurs.

C’est un beau résumé de l’évolution du SEO.

Comme tu le dis, tous ces secrets de polichinelle n’ont plus de raison d ‘être. Tout se sait tôt ou tard.