Google vient de dévoiler la mise à jour la plus ambitieuse d’AI Mode depuis son lancement. Déployée depuis quelques jours aux États-Unis, cette évolution majeure introduit trois innovations techniques qui transforment radicalement l’expérience de recherche : la recherche visuelle conversationnelle, le shopping en langage naturel, et une nouvelle architecture baptisée Visual Search Fan-Out. Pour les professionnels du digital marketing, comprendre ces nouveautés n’est pas optionnel : c’est une nécessité stratégique immédiate.

Loin d’une simple mise à jour incrémentale, Google franchit ici un cap technologique en fusionnant les capacités multimodales de Gemini 2.5 (son modèle d’IA capable de traiter simultanément texte et image) avec l’infrastructure éprouvée de Google Lens et son Shopping Graph. Le résultat ? Une interface de recherche qui comprend enfin ce que vous montrez autant que ce que vous dites.

Nouveauté #1 : La recherche visuelle devient conversationnelle

L’innovation centrale de cette mise à jour tient en une phrase : vous pouvez désormais poser une question en langage naturel et recevoir des résultats visuels riches, puis affiner votre recherche par itérations conversationnelles successives. Cette fonctionnalité représente une rupture avec le modèle classique « une requête = un ensemble de résultats ».

Concrètement, voici comment cela fonctionne. Imaginons que vous recherchez de l’inspiration déco avec une requête ouverte : « design maximaliste pour ma chambre ». AI Mode génère désormais une galerie visuelle correspondant à cette esthétique. Mais la vraie nouveauté intervient à l’étape suivante : au lieu de reformuler entièrement votre recherche, vous pouvez simplement ajouter « avec des tons sombres et des imprimés audacieux ». Le système comprend que vous affinez votre demande initiale et ajuste les résultats en conséquence.

Cette approche conversationnelle s’appuie sur la mémoire contextuelle de Gemini 2.5. Le modèle conserve le fil de la conversation et interprète chaque nouvelle instruction comme une modification incrémentale, pas comme une requête isolée. Pour les utilisateurs, cela signifie un parcours de recherche plus fluide et naturel. Pour les marketeurs, cela implique de repenser l’optimisation du contenu visuel.

Chaque image affichée dans les résultats inclut un lien cliquable vers la source, préservant ainsi l’écosystème web tout en offrant une expérience de découverte visuelle enrichie. Google maintient donc l’équilibre entre innovation UX et préservation du trafic vers les sites tiers : un détail crucial pour les stratégies SEO.

La dimension multimodale va encore plus loin : vous pouvez désormais démarrer votre recherche en uploadant une image ou en prenant une photo directement. AI Mode analyse alors cette image et génère des résultats visuels connexes, avec possibilité de raffiner par conversation. Cette fonctionnalité existait partiellement avec Google Lens, mais l’intégration dans AI Mode avec capacité conversationnelle représente un bond qualitatif significatif.

Nouveauté #2 : Le shopping conversationnel sans filtres

La deuxième innovation majeure concerne spécifiquement l’e-commerce. Google introduit une expérience shopping entièrement conversationnelle qui élimine le besoin de naviguer à travers des batteries de filtres traditionnels (taille, couleur, marque, prix, style, etc.).

Prenons l’exemple donné par Google : vous cherchez « les meilleurs jeans de weekend pour l’automne ». Plutôt que de cocher manuellement des dizaines de critères, vous affinez simplement en langage naturel : « des barrel jeans qui ne sont pas trop larges ». AI Mode interprète cette description subjective (« pas trop larges ») et génère une sélection visuelle de produits correspondants. Vous voulez encore ajuster ? Continuez la conversation : « je veux plus de longueur cheville ». Le système adapte instantanément les résultats.

Cette nouveauté repose sur deux piliers techniques. D’abord, le traitement du langage naturel (NLP) avancé de Gemini 2.5, capable d’interpréter des descriptions subjectives et contextuelles. Ensuite, le Shopping Graph de Google, cette base de données monumentale que nous allons détailler dans un instant.

L’expérience shopping reste shoppable : chaque produit affiché est cliquable et renvoie directement vers le site marchand pour finaliser l’achat. Google se positionne comme facilitateur de découverte, pas comme plateforme transactionnelle. Cette distinction est importante pour les e-commerçants : votre site reste le point de conversion finale, mais le parcours de découverte se déroule désormais dans l’interface Google.

Pour les professionnels du marketing digital, cette nouveauté impose une réflexion stratégique majeure. Les descriptions produits doivent désormais anticiper le langage conversationnel réel des utilisateurs. Au-delà des attributs techniques (« jean taille haute, coupe droite, 98% coton »), il faut intégrer des descriptions subjectives et contextuelles (« parfait pour un look décontracté mais soigné », « ni trop ajusté ni trop ample »). Le SEO e-commerce entre dans l’ère du conversational commerce.

Nouveauté #3 : L’architecture Visual Search Fan-Out

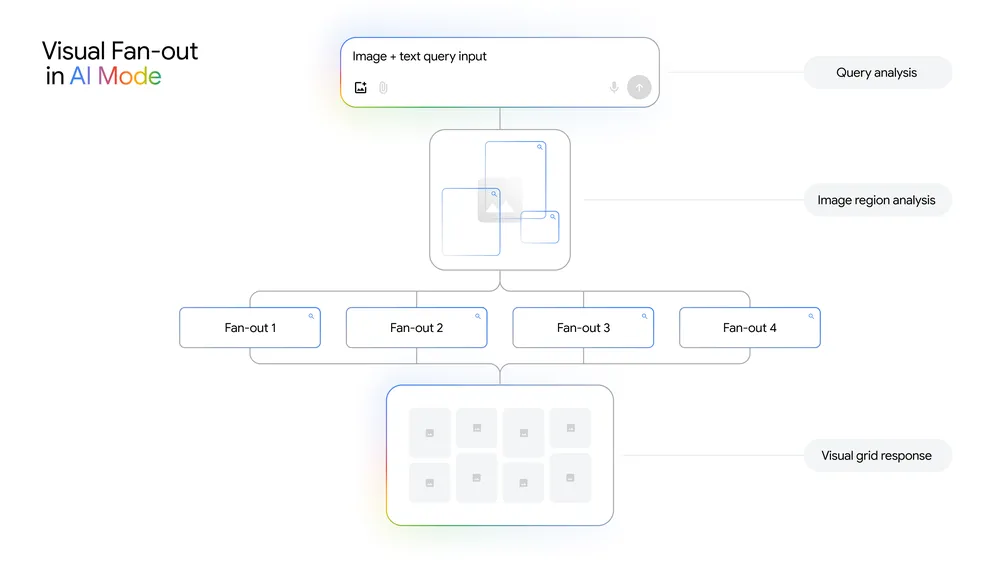

La troisième innovation est technique mais fondamentale : Google dévoile une nouvelle architecture baptisée Visual Search Fan-Out. Cette technique représente l’évolution logique du query fan-out existant, appliquée au domaine visuel.

Rappelons d’abord le concept de query fan-out : lorsqu’un utilisateur soumet une requête complexe à AI Mode, le système génère automatiquement plusieurs sous-requêtes parallèles en arrière-plan, interroge différentes sources, puis synthétise les résultats. Cette approche permet de traiter des questions multidimensionnelles avec une seule interaction utilisateur.

Le Visual Search Fan-Out transpose ce mécanisme au contenu visuel, avec une sophistication nouvelle. Lorsque vous soumettez une image, voici ce que le système accomplit :

- Analyse multiobjet : identification du sujet principal ET des éléments secondaires présents dans l’image

- Détection des détails subtils : textures, motifs, styles, palettes de couleurs, composition visuelle

- Génération de requêtes parallèles : création automatique de plusieurs recherches basées sur ces différents éléments

- Compréhension contextuelle : analyse de la relation entre les objets et l’esthétique globale

- Synthèse multimodale : fusion des résultats visuels avec la requête en langage naturel de l’utilisateur

Cette architecture s’appuie sur les capacités multimodales avancées de Gemini 2.5, capable de traiter simultanément les données visuelles et textuelles pour une compréhension holistique. Google combine également son expertise historique en computer vision (Google Lens, Image Search) avec les progrès récents de l’IA générative.

Prenons un exemple concret. Vous photographiez un salon avec un canapé velours émeraude, des coussins dorés et une table basse art déco. L’ancien système aurait principalement reconnu « canapé ». Le Visual Search Fan-Out analyse maintenant :

- Le canapé (forme, matière, couleur)

- Les coussins (style, coordination chromatique)

- La table basse (époque, design)

- L’harmonie d’ensemble (esthétique art déco, palette luxueuse)

Puis génère des requêtes parallèles pour chaque élément, permettant de proposer des alternatives ou compléments pertinents pour chaque objet ET pour l’esthétique globale.

L’implication pour le SEO visuel est considérable. Vos images produits ne sont plus indexées isolément mais dans leur contexte complet. Un coussin photographié dans un environnement stylisé bénéficie désormais du « halo sémantique » de tous les éléments visuels adjacents. L’optimisation visuelle devient une discipline holistique : la mise en scène, le contexte et l’esthétique globale de vos visuels influencent directement leur découvrabilité.

Le Shopping Graph : l’infrastructure qui change tout

Derrière ces innovations interface, Google dévoile les chiffres impressionnants de son Shopping Graph. Cette infrastructure mérite une attention particulière car elle sous-tend l’expérience shopping conversationnelle.

Le Shopping Graph est un graphe de connaissances e-commerce qui connecte et structure les données produits à l’échelle du web. Les métriques annoncées sont vertigineuses :

- Plus de 50 milliards de références produits indexées

- 2 milliards de mises à jour horaires des listings

- Couverture mondiale : des géants comme Amazon aux boutiques locales

- Données enrichies : avis, notes, promotions, variantes (tailles, couleurs), disponibilité en temps réel

Cette infrastructure représente des années d’investissement dans le crawling, le structuring et l’enrichissement des données e-commerce. Google agrège les flux Merchant Center, crawl les sites marchands, analyse les avis clients et monitore la disponibilité en temps quasi-réel.

La nouveauté dans cette mise à jour, c’est l’intégration profonde entre le Shopping Graph et les capacités conversationnelles de Gemini 2.5. Le modèle peut désormais interroger ce graphe avec des requêtes en langage naturel, interpréter des critères subjectifs, et retourner des résultats visuels pertinents. C’est la convergence entre une infrastructure de données robuste et une IA capable de comprendre l’intention humaine.

Pour les e-commerçants, trois impératifs émergent :

- Flux Merchant Center optimaux : données complètes, descriptions riches, attributs exhaustifs, images haute qualité

- Fraîcheur des données : avec 2 milliards de mises à jour horaires, les données obsolètes vous pénalisent immédiatement

- Signaux de qualité : avis clients, ratings, présence sur plusieurs canaux de distribution

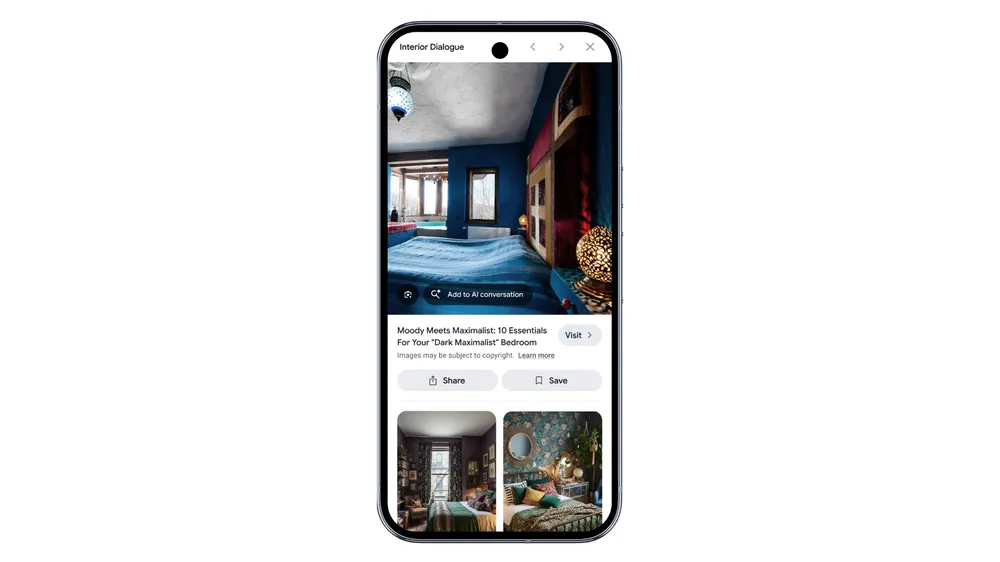

Recherche dans l’image : la fonctionnalité mobile exclusive

Google introduit également une fonctionnalité mobile spécifique qui pousse encore plus loin l’expérience multimodale : la possibilité de « rechercher à l’intérieur d’une image » avec des questions conversationnelles.

Concrètement, après avoir reçu des résultats visuels dans AI Mode, vous pouvez sur mobile sélectionner une image spécifique et poser des questions conversationnelles à son sujet. « Quelle est cette plante ? » « Dans quel style est ce meuble ? » « Où puis-je acheter ces coussins ? » Le système analyse l’image sélectionnée en profondeur et répond à vos questions spécifiques.

Cette fonctionnalité transforme chaque résultat visuel en point de départ d’une exploration approfondie. L’expérience devient véritablement exploratoire : vous découvrez visuellement, vous vous arrêtez sur ce qui vous intéresse, vous questionnez, vous affinez. Le parcours de recherche n’est plus linéaire mais arborescent.

D’un point de vue technique, cette capacité s’appuie sur une combinaison de computer vision (pour analyser les détails de l’image sélectionnée) et de NLP (pour interpréter la question conversationnelle). Gemini 2.5 joue ici pleinement son rôle de modèle multimodal unifié, capable de raisonner simultanément sur l’image et la question textuelle.

Disponibilité et déploiement

Cette mise à jour majeure commence son déploiement cette semaine aux États-Unis, exclusivement en anglais pour le moment. Google ne fournit pas de calendrier précis pour l’extension internationale, mais l’historique suggère un rollout progressif sur plusieurs mois.

Pour les équipes marketing internationales, cette phase initiale offre une fenêtre d’observation précieuse. Les professionnels hors US peuvent analyser l’adoption, observer les changements de comportement utilisateur, identifier les nouvelles opportunités SEO/SEA, et préparer leurs stratégies avant l’arrivée sur leurs marchés.

Les prérequis techniques pour bénéficier de cette visibilité sont clairs :

- Flux Google Merchant Center à jour (pour le shopping)

- Images haute qualité, contextualisées, optimisées

- Données structurées schema.org Product markup

- Descriptions conversationnelles et riches en langage naturel

- Stock et prix actualisés en temps réel

Trois innovations, une direction stratégique

Ces trois nouveautés — recherche visuelle conversationnelle, shopping en langage naturel, et architecture Visual Search Fan-Out — convergent vers une vision claire : transformer le search en assistant visuel et conversationnel.

Google ne veut plus être un simple moteur de recherche où l’on tape des mots-clés. L’ambition est de devenir une interface naturelle où l’on montre, on parle, on affine, on explore. L’IA ne se contente plus de trouver ce que vous cherchez ; elle comprend ce que vous voulez, même quand vous avez du mal à le formuler.

Pour les professionnels du digital marketing, ces innovations imposent une adaptation rapide :

- Audit visuel complet : qualité, contexte et diversité de vos assets visuels

- Optimisation conversationnelle : descriptions en langage naturel, anticipation des requêtes subjectives

- Excellence data : flux Merchant Center exhaustifs, structured data impeccable, fraîcheur garantie

- Monitoring continu : observation de l’évolution des sources de trafic, adaptation des stratégies d’acquisition

La fenêtre de déploiement US-only offre quelques mois pour se préparer. Utilisez-les stratégiquement : testez les fonctionnalités, identifiez les opportunités, formez vos équipes, et positionnez-vous pour être parmi les early adopters sur votre marché dès le lancement local.

Bibliographie et ressources complémentaires

Documentation officielle et ressources techniques

- Google AI Mode Official Documentation — Blog officiel présentant AI Mode et son évolution

- Query Fan-Out Technical Paper — Document technique détaillant l’architecture query fan-out

- Gemini 2.5 Multimodal Capabilities — Présentation des capacités multimodales du modèle

- Google Lens Technology Overview — Évolution des technologies de computer vision Google

Perspectives et analyses sectorielles

- Visual Search Trends 2025 — Études Google sur l’évolution de la recherche visuelle

- Conversational Commerce Report — Analyses sur le commerce conversationnel

- Multimodal AI in E-commerce: A Survey — Papers de recherche sur l’IA multimodale appliquée au retail