Le 12 septembre dernier, Google a décidé de désactiver le support du paramètre « num=100 » qui permettait d’afficher des pages présentant 100 résultats…

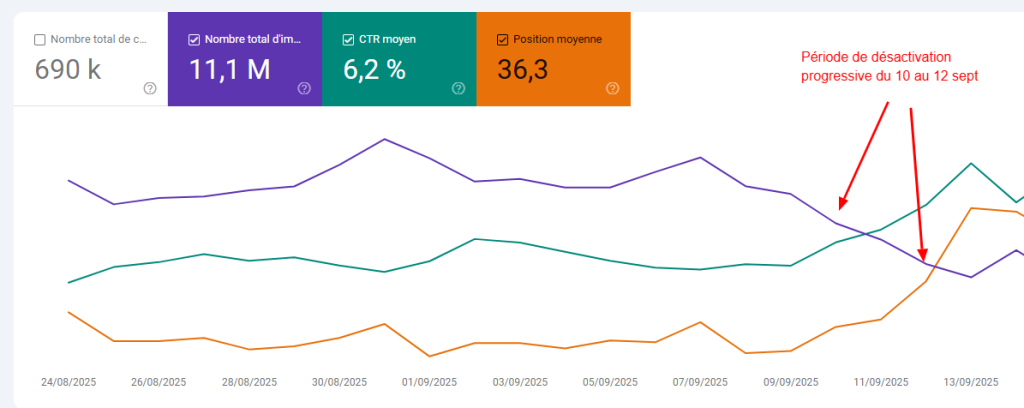

Cette désactivation a été progressive, elle était partielle le 10 mais complète le 12 septembre.

Pourquoi ? Google ne l’a pas révélé, mais ce filtre particulier était essentiellement utilisé par des outils de tracking de suivi de positions.

En effet, plutôt que d’aspirer dix pages de dix résultats, cela permettait d’effectuer une seule requête pour récupérer les 100 résultats. Il suffisait ensuite de considérer que les 10 premiers étaient en première page, les 10 suivants en seconde page etc..

Google siffle la fin de la récréation

Clairement, Google a choisi de rendre le crawl de ses pages de résultats encore plus coûteux qu’il ne l’est aujourd’hui. Déjà que les outils devaient déployer des trésors d’ingéniosité pour passer les filtres anti scraping de Google, voilà qu’il faut à présent qu’ils effectuent plusieurs requêtes là ou avant une seule suffisait.

Et cela a fortement perturbé le fonctionnement de ces outils pendant les jours qui ont suivi ce changement.

Depuis lors voici un aperçu de la situation :

- aHrefs envisage de réduire le nombre de positions reportés dans ses outils

- Accuranker annonce que leur analyse va s’arrêter aux 20 premiers résultats désormais

- SEOClarity a déclaré que ses utilisateurs ne seraient pas impactés

- SEMRush a annoncé qu’ils vérifieraient les positions moins souvent et qu’ils instaurent des limitations temporaires

- Sistrix a annoncé qu’ils allaient s’adapter

- Haloscan annonce que ses tarifs augmenteront pour les nouveaux abonnements

- Dataforseo a changé ses tarifs en conséquence (le tarif pour avoir 100 résultats est multiplié … par 10)

- etc.

Un impact visible sur le rapport performances de la GSC

Juste après ce changement, la plupart des sites ont vu un changement très visible dans les rapports de la GSC :

- le nombre d’impressions est en nette baisse

- la position moyenne est en hausse

- les clics sont inchangés

- le CTR est en hausse

La cause probable : une grande part du nombre d’impressions reporté dans la GSC étaient en fait causés par des visites artificielles provenant des bots des outils de suivi de position. Ces bots ne cliquant pas sur les résultats, cela fait augmenter le CTR (le ratio clics/impressions). Pour la position moyenne, elle est mesurée en fonction des cas déclenchant des impressions, d’où la aussi une hausse de l’indicateur, certaines positions faibles n’étant plus jamais affichées.

Notons que ce phénomène se voit beaucoup moins sur des sites à fort trafic, car la part du trafic de bots supprimé représente pour ces sites un pourcentage très faible du trafic global.

Quel impact réel pour votre SEO ?

Cette décision n’a pas d’impact réel, si ce n’est sur votre perception des performances : si vous constatez que ces indicateurs s’améliorent, cela ne signifie pas que votre SEO s’améliore. Juste que c’était mal mesuré avant.

Cela signifie aussi que suivre ses positions avec un outil :

- soit coûtera dorénavant plus cher

- soit se fera avec une dégradation du niveau de données obtenues

Google n’a jamais souhaité rendre la vie facile à l’écosystème d’outils SEO quand il lui coûte des ressources. Mais cet épisode sonne presque comme une déclaration de guerre.