Le 5 février 2026, Google a fait quelque chose qu’il n’avait jamais fait auparavant.

L’entreprise a publié une core update (mise à jour majeure de l’algorithme) ciblant exclusivement Google Discover, son flux de contenus personnalisés accessible depuis l’application mobile Google et la page d’accueil de Chrome sur smartphone. Jusqu’ici, les core updates touchaient la recherche classique, et leurs effets sur Discover n’étaient qu’un sous-produit collatéral. Cette fois, Discover est traité comme un environnement de classement autonome, avec ses propres critères de qualité.

Pour les éditeurs, les sites de presse et les médias en ligne, ce n’est pas un ajustement cosmétique. C’est un changement de paradigme. Discover représente pour certaines publications une part considérable du trafic entrant, parfois davantage que la recherche organique classique. La core update de février 2026 vient changer les règles du jeu.

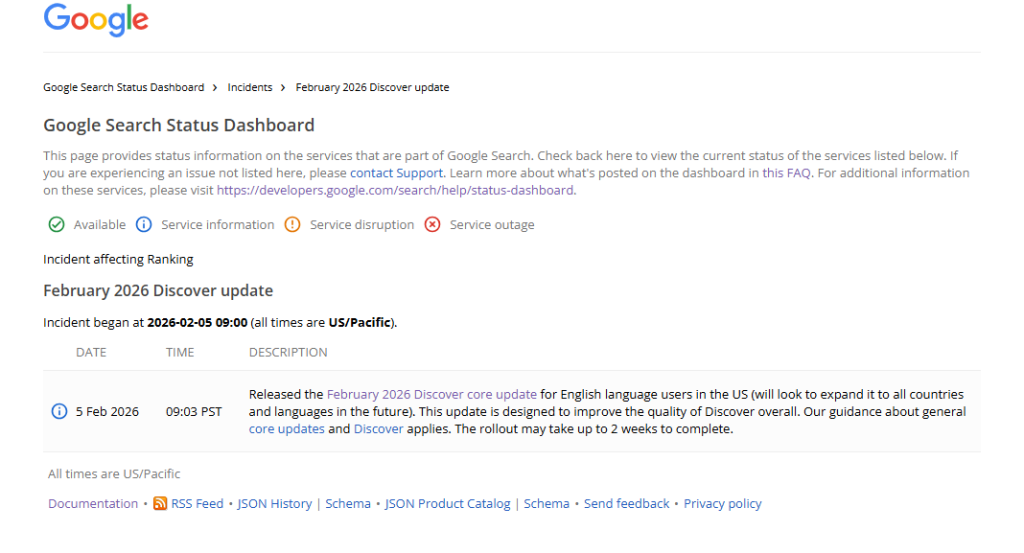

Le déploiement a débuté le 5 février pour les utilisateurs anglophones aux États-Unis, avec une durée estimée de deux semaines. Google a confirmé une extension mondiale dans les mois à venir.

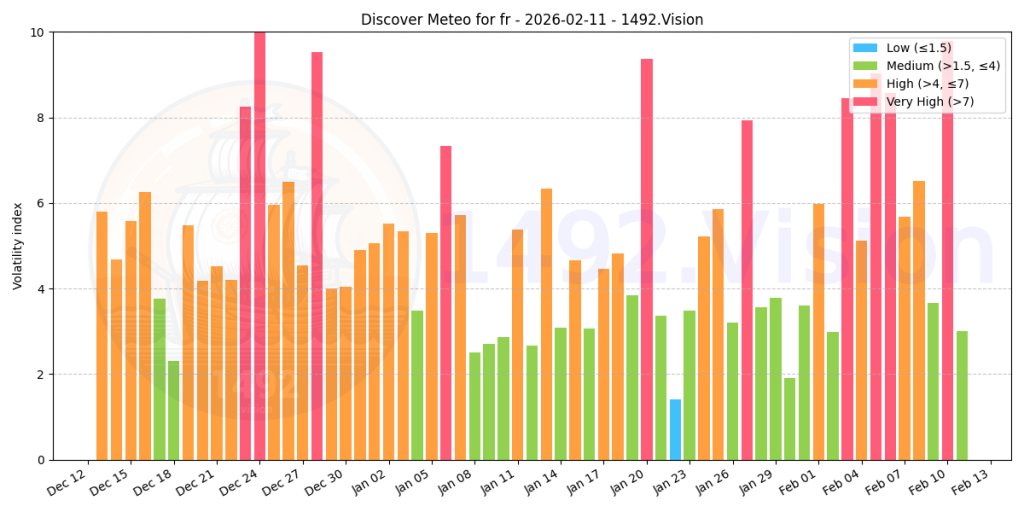

Bizarrement, les flux Discover ont beaucoup bougé en France autour de la même période, si l’on en croit la météo Discover de l’outil 1492.vision :

L’annonce a été publiée sur le blog Search Central par John Mueller, Search Advocate chez Google, et enregistrée sur le Search Status Dashboard (le tableau de bord public où Google signale les mises à jour algorithmiques en cours). Pour la communauté SEO, qui s’attendait à une core update classique touchant le Search, la surprise a été totale.

Discover n’est plus un simple bonus : c’est un canal à part entière

Pour bien comprendre l’ampleur du changement, il faut revenir sur ce qu’est Google Discover. Contrairement à la recherche classique, où l’utilisateur tape une requête et obtient des résultats, Discover fonctionne de manière proactive. Il propose des articles, des vidéos et des contenus à l’utilisateur sans qu’il n’ait rien demandé, en se basant sur ses centres d’intérêt, son historique de navigation et son activité sur le web.

Ce flux de contenus, affiché principalement sur mobile, est devenu pour de nombreux médias un levier d’audience majeur. Certains sites de presse y puisent entre 20 % et 60 % de leur trafic organique total. Mais contrairement au SEO classique, où l’on optimise des pages pour des mots-clés identifiés, Discover ne repose sur aucune requête utilisateur. Il n’y a pas de mots-clés à cibler, pas de position à tracker. Le contenu est soit surfacé, soit invisible.

Jusqu’à présent, Google avait déclaré à plusieurs reprises que les performances sur Discover étaient liées aux performances dans le Search, dans la mesure où l’algorithme de Discover réutilisait des scores de l’algorithme Search Classique. A l’occasion de cette core update de février 2026, la communication de Google a changé. Google affirme désormais que les systèmes de Discover évaluent le contenu selon des critères distincts de ceux du Search. La performance sur un canal ne garantit plus la performance sur l’autre.

Trois axes de changement, une seule philosophie

Google a structuré cette mise à jour autour de trois priorités explicites. Chacune d’entre elles mérite une lecture attentive, car elles redéfinissent les critères de visibilité dans Discover.

Priorité au contenu local

Discover affichera désormais davantage de contenus issus de sites géographiquement proches de l’utilisateur. Un lecteur situé au Texas verra plus de résultats provenant de médias Texans. .

Réduction du clickbait et du sensationnalisme

C’est le volet le plus visible de la mise à jour. Google a révisé sa documentation officielle « Get on Discover » en déplaçant les recommandations anti-clickbait en tête de liste, un signal clair de priorisation.

La documentation distingue désormais deux comportements sanctionnés :

- Le clickbait au sens strict : titres trompeurs, images sans rapport avec le contenu, rétention intentionnelle d’informations essentielles pour forcer le clic.

- Les tactiques de sensationnalisme : contenus qui jouent sur la curiosité morbide, la provocation, l’indignation ou l’excitation artificielle.

Cette distinction est importante. Un titre peut ne pas être techniquement « trompeur » mais relever du sensationnalisme s’il exploite l’émotion pour gonfler l’engagement. Google vise les deux pratiques.

Expertise thématique évaluée sujet par sujet

C’est le changement le plus profond et celui qui aura le plus d’impact à moyen terme. Google introduit le concept de topic-by-topic expertise (expertise évaluée thème par thème). Concrètement, cela signifie que l’autorité d’un site n’est plus mesurée comme un signal global appliqué à l’ensemble du domaine. Elle est évaluée pour chaque sujet couvert.

Un grand média généraliste qui couvre la politique, l’économie, le sport et la culture ne sera pas considéré comme également expert sur tous ces sujets. Ses articles politiques pourront être surfacés dans Discover si le corpus politique du site démontre une profondeur suffisante, tandis que ses contenus sportifs pourraient être ignorés si la couverture est superficielle.

Google le formule ainsi dans son annonce : « Nos systèmes sont conçus pour identifier l’expertise sur une base thématique. Qu’un site démontre une expertise dans plusieurs domaines ou se concentre profondément sur un seul sujet, les chances d’apparaître dans Discover sont égales. »

Un système de ce type existait bien déjà dans l’ancienne version de l’algorithme. De quel changement parle-t’on ici : d’un topic layer plus fin ? d’une montée dans le niveaux d’exigence sur la légitimité sur un sujet précis ? L’avenir nous le dira

La « page expérience » entre dans l’équation Discover

Au-delà des trois axes principaux, la documentation révisée introduit un critère qui n’y figurait pas auparavant : la page experience (expérience de page). Ce terme désigne l’ensemble des signaux techniques qui mesurent la qualité de l’expérience utilisateur sur une page web, incluant les Core Web Vitals (les trois métriques de performance que sont le LCP, le FID/INP et le CLS).

- Le LCP (Largest Contentful Paint) mesure le temps de chargement du plus grand élément visible de la page.

- L’INP (Interaction to Next Paint), qui a remplacé le FID en 2024, mesure la réactivité de la page aux interactions utilisateur.

- Le CLS (Cumulative Layout Shift) mesure la stabilité visuelle de la page pendant le chargement, c’est-à-dire les décalages de mise en page inattendus.

Cette inclusion dans les critères Discover est cohérente avec l’algorithme de recherche classique de Google, qui intègre déjà ces signaux. Mais son ajout explicite à la documentation Discover signale que les pages lentes, instables ou encombrées de publicités intrusives seront désormais pénalisées aussi dans le flux personnalisé.

Ce que les éditeurs doivent faire concrètement

Repenser la titraille

C’est le chantier le plus urgent. Chaque titre doit résumer fidèlement le contenu de l’article. En clair, pas de titres ou de visuels trompeurs; pas de titres déceptifs non plus (laisser penser qu’on va trouver une info sur le site, alors que… non).

Pour les rédactions habituées à optimiser le CTR (Click-Through Rate, le taux de clics) avec des titres accrocheurs, le réglage est subtil. Il ne s’agit pas de produire des titres fades, mais des titres informatifs et engageants qui ne sacrifient pas la clarté au profit de la curiosité artificielle.

Construire une profondeur thématique vérifiable

Si votre site couvre cinq thématiques, chacune doit disposer d’un corpus éditorial conséquent : articles de fond, analyses, dossiers, interviews d’experts. Les rubriques alimentées uniquement par de la reprise de dépêches ou du contenu agrégé sans valeur ajoutée risquent de ne plus être reconnues comme des zones d’expertise par les systèmes de Google.

Auditer l’expérience mobile

L’audit technique doit se concentrer sur trois points :

- Les Core Web Vitals : corriger toutes les URLs en statut « poor » dans la Search Console.

- L’ordre de chargement : le titre et le corps de l’article doivent être les premiers éléments visibles, avant toute publicité ou élément interactif.

- Les éléments bloquants : supprimer ou réduire les interstitiels (écrans qui s’affichent par-dessus le contenu, comme les pop-ups newsletter ou les murs publicitaires), les pop-ups plein écran et les murs de cookies surdimensionnés.

Pour les images, Google recommande à nouveau une largeur minimale de 1200 pixels et l’activation de la balise max-image-preview:large dans les meta robots. Il est aussi précisé de ne pas utiliser le logo du site comme image d’article.

Pour en savoir plus, inscrivez-vous à notre webinaire le 19 février 2026 à 11h avec Damien Andell et Sylvain Deauré de 1492.vision :

https://www.linkedin.com/events/7424384325669855232?viewAsMember=true

Bibliographie et lectures complémentaires

- Google’s February 2026 Discover Core Update : l’annonce officielle de Google sur le blog Search Central, point de départ indispensable.

- Get on Discover : la documentation officielle révisée de Google sur les bonnes pratiques pour apparaître dans Discover.

- Traffic Impact of Google Discover Update : l’analyse de Practical Ecommerce sur l’impact trafic et les nouvelles guidelines.

- February 2026 Google Discover Core Update Rolling Out : le suivi en temps réel de Barry Schwartz sur Search Engine Roundtable, avec les premiers retours de la communauté.