Google vient d’annoncer le déploiement d’un tout nouveau User Agent pour un nouveau type de crawler. Cela chamboule un peu le paysage des différents « bots » de Google, ce qui se reflète aussi dans les pages supports sur la question.

GoogleOther, le nouveau bot de Google

Un petit nouveau vient de faire son apparition dans la liste des bots de Google : GoogleOther.

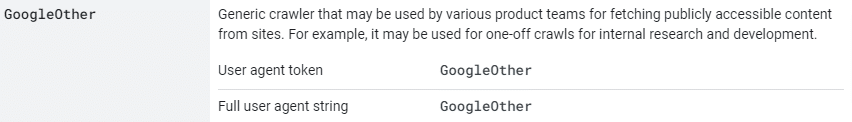

Son user agent est « GoogleOther » tout court, et il est décrit comme un « crawler générique qui peut être utilisé par différentes équipes produits [de Google] pour aller télécharger des contenus publiquement accessibles sur des sites internet ».

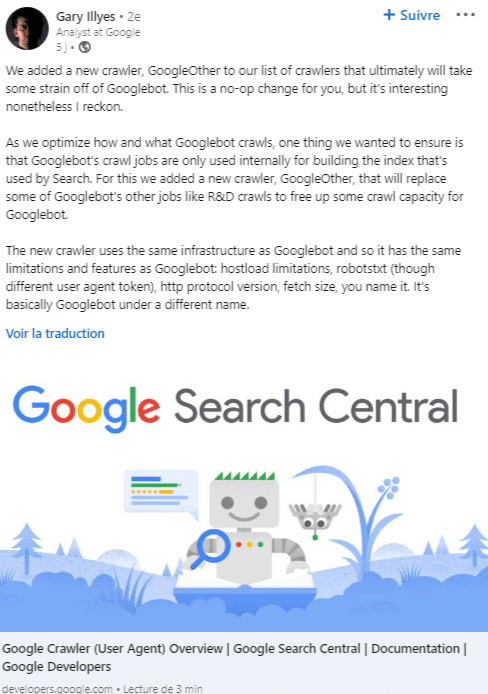

Gary Illyes a donné quelques précisions sur les usages de ce nouveau « bot » via un post LinkedIn

Visiblement, il s’agit d’un bot qui permettra de crawler le web de manière séparée de Googlebot, à des fins de recherche ou de tests.

Google en profite pour restructurer sa liste de bots dans les pages supports

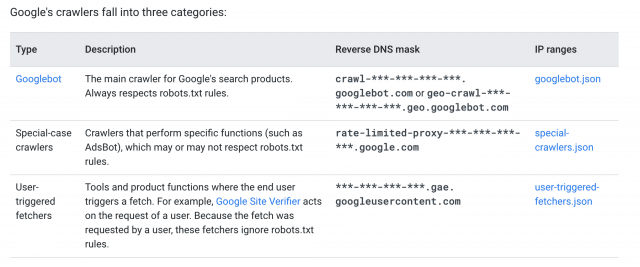

Quelques heures après cette annonce, la page de support sur les bots de Google a été modifiée (dans sa version anglaise pour l’instant).

https://developers.google.com/search/docs/crawling-indexing/overview-google-crawlers#googleother

La liste des bots apparait dans un ordre différent. Et elle est scindée en trois groupes de bots :

- les bots « communs » à plusieurs outils/usages. Googlebot, Googlebot Images, GoogleOther font partie de cette catégorie

- les bots « spécifiques » à un outil (par exemple Adsbot)

- les bots « déclenchés par l’utilisateur » comme le Google Site Verifier. Ces bots téléchargent une page suite à une action de l’utilisateur

Pas d’autres changements à noter : c’est juste plus clair comme cela.

Euh… faut-il que je modifie mon robots.txt ?

Suite à cette annonce, beaucoup ont réagi de manière un peu excessive en se disant : zut, il va falloir mettre à jour mon robots.txt.

Sauf que… non. Si vous ne le faites pas, il ne se passera pas grand chose.

Si vous ne bloquez pas ce nouveau User Agent, par défaut il pourra crawler vos pages librement, c’est tout. Aucun impact positif ou négatif pour votre SEO à attendre.

Si vous voulez économiser de la bande passante, vous pouvez ajouter un bloc d’instructions pour empêcher ce bot de crawler vos pages. Pas sûr que cela arrangera les ingénieurs de Google, mais c’est votre site, vous avez le droit.

Si vous voulez tout bloquer :

User-agent: GoogleOther

Disallow: /

Et si vous voulez juste empêcher Google d’avoir accès à des données sensibles (par exemple, des pages du back office), n’hésitez pas à les bloquer aussi pour GoogleOther.

Exemple pour un site wordpress :

User-agent: * # On empêche l'indexation des dossiers sensibles Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /trackback Disallow: /feed Disallow: /comments Disallow: /category/*/* Disallow: */trackback Disallow: */feed Disallow: */comments Disallow: /*.pdf$ # On désindexe toutes les URL ayant des paramètres (duplication de contenu) Disallow: /*?* Disallow: /*? # On désindexe la page de connexion (contenu inutile) Disallow: /wp-login.php # On autorise l'indexation des images Allow: /wp-content/uploads User-agent: Googlebot Disallow: /*.php$ Disallow: /*.inc$ Disallow: /*.gz$ Disallow: /*.pdf$ User-agent: GoogleOther # On empêche l'indexation des fichiers sensibles Disallow: /*.php$ Disallow: /*.inc$ Disallow: /*.gz$ Disallow: /*.pdf$